عصر گویش | هوش مصنوعی

Открыть в Telegram

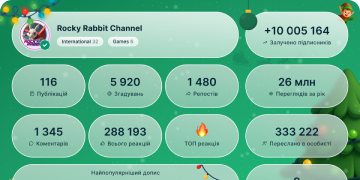

2025 год в цифрах

111 739

Подписчики

-12224 часа

-7287 дней

-3 15730 день

Загрузка данных...

Похожие каналы

Облако тегов

Входящие и исходящие упоминания

---

---

---

---

---

---

Привлечение подписчиков

декабрь '25

декабрь '25

+3

в 0 каналах

ноябрь '25

+1

в 0 каналах

Get PRO

октябрь '25

+5

в 0 каналах

Get PRO

сентябрь '25

+4

в 0 каналах

Get PRO

август '25

+1

в 0 каналах

Get PRO

июль '250

в 0 каналах

Get PRO

июнь '250

в 0 каналах

Get PRO

май '25

+2

в 0 каналах

Get PRO

апрель '250

в 0 каналах

Get PRO

март '250

в 0 каналах

Get PRO

февраль '250

в 0 каналах

Get PRO

январь '250

в 0 каналах

Get PRO

декабрь '240

в 0 каналах

Get PRO

ноябрь '240

в 0 каналах

Get PRO

октябрь '240

в 0 каналах

Get PRO

сентябрь '240

в 0 каналах

Get PRO

август '240

в 0 каналах

Get PRO

июль '240

в 0 каналах

Get PRO

июнь '240

в 0 каналах

Get PRO

май '240

в 0 каналах

Get PRO

апрель '24

+436

в 0 каналах

Get PRO

март '24

+1 995

в 0 каналах

Get PRO

февраль '24

+4 710

в 0 каналах

Get PRO

январь '24

+8 226

в 0 каналах

Get PRO

декабрь '23

+17 536

в 0 каналах

Get PRO

ноябрь '23

+7 333

в 0 каналах

Get PRO

октябрь '23

+10 290

в 0 каналах

Get PRO

сентябрь '23

+14 122

в 0 каналах

Get PRO

август '23

+5 479

в 1 каналах

Get PRO

июль '23

+8 350

в 0 каналах

Get PRO

июнь '23

+338

в 0 каналах

Get PRO

май '23

+196 092

в 0 каналах

| Дата | Привлечение подписчиков | Упоминания | Каналы | |

| 26 декабря | 0 | |||

| 25 декабря | 0 | |||

| 24 декабря | 0 | |||

| 23 декабря | 0 | |||

| 22 декабря | 0 | |||

| 21 декабря | 0 | |||

| 20 декабря | 0 | |||

| 19 декабря | 0 | |||

| 18 декабря | 0 | |||

| 17 декабря | 0 | |||

| 16 декабря | 0 | |||

| 15 декабря | 0 | |||

| 14 декабря | 0 | |||

| 13 декабря | 0 | |||

| 12 декабря | 0 | |||

| 11 декабря | 0 | |||

| 10 декабря | 0 | |||

| 09 декабря | 0 | |||

| 08 декабря | 0 | |||

| 07 декабря | 0 | |||

| 06 декабря | 0 | |||

| 05 декабря | +1 | |||

| 04 декабря | +2 | |||

| 03 декабря | 0 | |||

| 02 декабря | 0 | |||

| 01 декабря | 0 |

Посты канала

🧠🔊 مغز چگونه واژههای شنیداری را میسازد؟

گزارشی از یک پژوهش جدید در علوم اعصاب شناختی

📄 پژوهشی تازه منتشرشده در ScienceDirect نشان میدهد که مغز انسان چگونه گفتار پیوسته را به واژههای مجزا و معنادار تبدیل میکند؛ مسئلهای که سالها یکی از چالشهای اصلی علوم اعصاب زبان بوده است.

🎯 مسئله اصلی چیست؟

گفتار طبیعی مرزهای واضحی بین واژهها ندارد، اما ما بدون زحمت آن را به کلمات جداگانه درک میکنیم.

❓ سؤال کلیدی: مغز این مرزبندی را چطور انجام میدهد؟

🧪 روش پژوهش

🔹 ثبت مستقیم فعالیت قشر مغز انسان با الکتروکورتیکوگرافی (ECoG)

🔹 تمرکز روی ناحیهی STG (شیار گیجگاهی فوقانی)

🔹 گوش دادن شرکتکنندگان به گفتار طبیعی و داستانمحور

این روش امکان مشاهدهی دقیق دینامیک زمانی نورونها را فراهم کرده است.

🧠 یافتههای کلیدی

🔄 ۱. ریست عصبی در مرز واژهها

فعالیت نورونی در STG در مرز بین واژهها بهطور مشخصی کاهش مییابد؛

📌 مغز از این «بازنشانی» برای تشخیص پایان و آغاز واژهها استفاده میکند.

📊 ۲. رمزگذاری چندلایه داخل هر واژه

بین دو ریست:

ویژگیهای آکوستیکی (واجها)

اطلاعات آهنگ و ریتم گفتار

و حتی نشانههای معنایی

بهصورت همزمان و پویا رمزگذاری میشوند.

⏱️ ۳. زمان نسبی مهمتر از زمان مطلق است

مغز واژهها را نه بر اساس طول واقعیشان، بلکه بر اساس پیشرفت نسبی درون هر واژه پردازش میکند.

📌 نتیجه: انعطاف بالا در درک واژههای کوتاه و بلند.

🤖 ۴. شباهت شگفتانگیز با مدلهای هوش مصنوعی

الگوی فعالیت مغز شباهت زیادی به شبکههای عصبی خودنظارتی گفتار دارد.

🔹 نشانهای از همگرایی میان علوم اعصاب و مدلهای یادگیری عمیق.

🧪 آزمون ادراک

در وظایف ادراک دوپایدار: 🧠 پاسخهای مغزی دقیقاً با ادراک ذهنی فرد از مرزهای واژهها همراستا بود.

یعنی مغز نهفقط صدا، بلکه «آنچه شنیده میشود» را بازنمایی میکند.

🧩 جمعبندی

✅ مغز از یک مدل دینامیکی و چرخهای برای ساخت واژهها استفاده میکند

✅ مرزهای واژه با ریستهای عصبی مشخص میشوند

✅ اطلاعات صوتی، آهنگین و معنایی بهصورت یکپارچه ادغام میشوند

✅ این سازوکار بسیار شبیه معماریهای مدرن هوش مصنوعی است

🚀 اهمیت پژوهش

🔹 درک عمیقتر زبان در مغز انسان

🔹 الهام برای مدلهای پیشرفتهی پردازش گفتار

🔹 کاربرد بالقوه در BCI، درمان اختلالات زبانی و هوش مصنوعی گفتارمحور

📎 منبع علمی:

Human cortical dynamics of auditory word form encoding

ScienceDirect – 2025

@asrgooyeshpardaz

32930

| 2 | 🦾ربات Unitree با سامانهٔ تلهاپریشن (Teleoperation) و دریافت حرکات بدن (Motion Capture)

#رباتها

@asrgooyeshpardaz | 442 |

| 3 | 👩💻 روش SSR: خودآموزی عاملهای هوش مصنوعی بدون دادههای انسانی

پژوهشگران شرکت Meta روشی به نام Self-play SWE-RL (SSR) معرفی کردهاند؛ روشی که به عاملهای هوش مصنوعی اجازه میدهد بدون دخالت انسان و با کار روی کدبیسهای واقعی، بهصورت خودکار آموزش ببینند. 🚀

🔧 چگونه کار میکند؟

یک هوش مصنوعی همزمان دو نقش را بازی میکند:

1️⃣ ایجادکنندهٔ باگ — عمداً در کد خطا ایجاد میکند و تستها را تضعیف میکند.

2️⃣ اصلاحکننده — این باگها را پیدا کرده و برطرف میکند.

هر دو نقش با استفاده از یادگیری تقویتی (Reinforcement Learning) آموزش میبینند و بهتدریج وظایف پیچیدهتری برای یکدیگر میسازند. 🧩

📊 نتایج:

• روش SSR بهبود +۱۰٫۴ امتیاز در SWE-bench Verified و +۷٫۸ امتیاز در SWE-bench Pro نشان داده است.

• عملکرد آن از روشهای پایهٔ RL که با دادههای انسانی آموزش دیدهاند نیز بهتر بوده است.

📈 نکتهٔ کلیدی:

هوش مصنوعی بهصورت کاملاً خودمختار، با کاوش در ریپازیتوریها و بدون نیاز به تستهای آماده یا توضیحات issue یاد میگیرد.

این رویکرد گامی مهم بهسوی عاملهای فوقهوشمند است؛ عاملهایی که میتوانند نرمافزار را از صفر درک کنند، اشکالزدایی کنند و حتی خودشان تولید کنند. 🤖💻

🔗 لینک مقاله:

https://arxiv.org/abs/2512.18552

#هوش_مصنوعی #عاملها #پژوهشها

@asrgooyeshpardaz | 488 |

| 4 | جمعبندی کارپثی از داستان LLMها در ۲۰۲۵

اینفلوئنسر محبوبم آقای آندرهآ کارپثی، در یک بلاگ کوتاهی برداشتهای خودش از LLMها در سال ۲۰۲۵ رو به اشتراک گذاشته. بخشهای مهمش اینها هستند:

1. Reinforcement Learning from Verifiable Rewards (RLVR)

2. Ghosts vs. Animals / Jagged Intelligence

3. Cursor / new layer of LLM apps

4. Claude Code / AI that lives on your computer

5. Vibe coding

6. Nano banana / LLM GUI

۱- کارپثی معتقده که RLVR یکی از مهمترین اتفاقات هوش مصنوعی در سال گذشته بوده و میشه گفتش که یک استیج جدید روی استیجهای قبلی که PT و SFT و RLHF بودند اضافه شده و اعتقاد داره که RLVR بوده که به خاطر خواصش باعث شده که مدلها به توانایی استدلال دست پیدا کنند.

۲- یک اعتقاداتی درباره ماهیت و ذات هوش و هوش مصنوعی داره که در این بخش دربارهاش صحبت کرده. میگه که فضای هوش چیزی گستردهتر از تصور اولیه ماست و سنجیدن هوش LLM با حیوانات کار ممکنی نیست. معتقده که LLM بیشتر شبیه به یک روحی هست که عصاره هوش انسانی درش بروز پیدا کرده و پشت فضای واقعی دنیا در حال تعامل هست (استعاره بسیار عمیق). از یک طرف دیگه هم میگه که هوش LLMها هنوز دندانهدار هست یعنی در یک دامینی خوبه ولی اندکی که از اون دامین خارج میشیم ابله هست و برای همین هنوز تا AGI فاصله داریم. در کنار اینها هم میگه که بنچمارکها چون همیشه قابل سنجش هستند (یعنی جواب درست/غلط دارند) پس همیشه در معرض این هستیم که با تولید داده و انجام RLVR روی بنچمارکها مدلهامون روی اونها پیروز کنیم در حالی که هنوز جنبه واقعی هوش نرسیده باشیم (این تکهاش کراس اوری هست با اون نگاهی که راجع به RLVR داشت، در واقع میگه که با این که RLVR به ما اجازه داد که هر چیز قابل سنجشی رو روش آموزش بدیم مدلهامون رو ولی نشون داد که یک چیزهایی فراتر از قلمرو راستیآزماییپذیری انگار وجود دارند) یک صحبت جالب دیگه هم داشت که میگفت هر شغلی که قابلیت راستیآزماییپذیری بیشتری داشته باشه سریعتر هم توسط هوش مصنوعی جایگزین میشه (مثل مهندسی نرم افزار مثلا).

۳- در مورد Cursor صحبتی که میکنه میگه که Cursor یک لایه جدید ابسترکشن از LLM appها رو معرفی کرد. شما میتونید به جای کرسر برید با GPT صحبت کنید و ازش کد بگیرید ولی کرسر روی اون نیازمندی خاص شما اومده یک جور context engineering انجام داده و تعامل شما با llm رو جوری مهندسی کرده که کار شما رو راحت کرده. بر همین اساس احتمالا در آینده شاهد اپهای مختلف تری روی همین ابسترکشن شبیه cursor منتها برای دامینها و نیازمندیهای دیگه خواهیم بود. مثلا فرض کنید cursor برای آموزش یا رواندرمانی چه شکلی میتونن باشند.

۴- یک صحبتی هم راجع به Cursor Code کرده که به نظرش از این حیث که روی کامپیوتر شما اجرا میشه و قابلیت Agency داره جالبه. به نظرش شبیه یک روحی هست که در محیط کامپیوتر شما زندگی میکنه.

۵- راجع به vibe coding حرف میزنه و میگه که خودش ازش خیلی استفاده کرده. خودش مثلا Rust بلد نبوده ولی با vibe coding تونسته توکنایزرهای بر پایه rust بزنه و کلا معتقده که وایب کدینگ مفهوم برنامهنویسی و شرح وظایف رو تغییر میده.

۵- و در نهایت هم Nano Banana. حضرت کارپثی میگه که این که ما چطور و از طریق چه رابطی با انسان رابطه برقرار کنیم یک مساله مهمیه. همین الان بخش مهمی از تعاملات llm با انسان از طریق markdown صورت میگیره و اگر markdownای وجود نداشت تجربه کار با llmها سخت میشد. بر همین جنبه معتقده که ارائه تصویر (مثل ارائه اسلاید، نمودار، اینفوگرافی) به انسان بسیار موثرتر هست تا ارائه متن خالی و برای همین نانوبنانا رو یک جهش بزرگ در عرصه رابطه کاربری بین انسان و هوش مصنوعی میدونه.

در نهایت همین TLDR از صحبتهاش:

TLDR. 2025 was an exciting and mildly surprising year of LLMs. LLMs are emerging as a new kind of intelligence, simultaneously a lot smarter than I expected and a lot dumber than I expected. In any case they are extremely useful and I don't think the industry has realized anywhere near 10% of their potential even at present capability. Meanwhile, there are so many ideas to try and conceptually the field feels wide open. And as I mentioned on my Dwarkesh pod earlier this year, I simultaneously (and on the surface paradoxically) believe that we will both see rapid and continued progress and that yet there is a lot of work to be done. Strap in.

لینک:

https://karpathy.bearblog.dev/year-in-review-2025/

پینوشت: از این که پستهای کانال رو به اشتراک میگذارید از شما ممنونیم. | 497 |

| 5 | 🚀 مدل MiniMax M2.1 — اکنون متنباز و یکی از بهترین مدلهای هوش مصنوعی برای توسعهدهندگان

— کسب نتایج برتر در بنچمارکهای کدنویسی

(SWE، VIBE، Multi-SWE)

— در تعدادی از آزمونها عملکردی بهتر از Gemini 3 Pro و Claude Sonnet 4.5 دارد

— دارای معماری MoE (ترکیب متخصصها): تنها ۱۰ میلیارد پارامتر بهصورت فعال استفاده میشوند (در مجموع ۲۳۰ میلیارد پارامتر)

و این فقط اعداد نیستند؛

این مدل در استنتاج (Inference) بسیار سریع است و دیپلوی کردن آن ساده میباشد؛

حتی میتوان آن را بهصورت محلی (Local) اجرا کرد.

لینک مدل:

https://huggingface.co/MiniMaxAI/MiniMax-M2.1

@asrgooyeshpardaz | 499 |

| 6 | 🤖 مهارتهای عاملها برای مهندسی کانتکست (Agent Skills for Context Engineering) —

آموزش «فکر کردن با کانتکست» به عاملها

این مخزن (Repository) نشان میدهد چگونه میتوان عاملهای مبتنی بر LLM را ارتقا داد تا بهجای صرفاً تولید پاسخ، درک عمیقتری از مسئله، تاریخچه گفتگو و شرایط حاکم داشته باشند.

🔍 این پروژه چه فایدهای دارد؟

🔹 آموزش مهارتهای مدیریت کانتکستهای طولانی

🔹 ساختاربندی دقیق دادهها و دستورالعملها

🔹 ارائه الگوهایی برای جستجو، فیلتر کردن و تصمیمگیری

🔹 نمونههایی از سناریوهای واقعی (چتها، وظایف دارای حافظه، یکپارچهسازیها)

❗ مسئلهای که حل میکند

عاملها اغلب:

جزئیات مهم را از دست میدهند،

مراحل را با هم قاطی میکنند،

یا «هدف اصلی» را فراموش میکنند.

این کتابخانه به آنها یاد میدهد چگونه:

کانتکست را تحت کنترل نگه دارند،

و بهصورت منسجم و مرحلهبهمرحله عمل کنند.

🔗 گیتهاب:

https://github.com/muratcankoylan/Agent-Skills-for-Context-Engineering

@asrgooyeshpardaz | 805 |

| 7 | 📊 شتاب رشد هوش مصنوعی دو برابر شده، اما اعتماد به بنچمارکها کاهش یافته است: گزارش Epoch AI

در گزارش سال ۲۰۲۵، مؤسسه Epoch AI از شتابگیری چشمگیر پیشرفت هوش مصنوعی خبر میدهد. بر اساس دادههای تحلیلی، این صنعت از یک «نقطه عطف» عبور کرده است: سرعت بهبود شاخصهای مدلهای SOTA تقریباً دو برابر شده و از ۸ به ۱۵ واحد در شاخص عملکرد سالانه رسیده است. موتورهای اصلی این رشد، گذار گسترده به مدلهای مبتنی بر استدلال (Reasoning Models) و تمرکز بیشتر بر یادگیری تقویتی (RL) عنوان شدهاند.

با این حال، گزارش به یک چالش جدی اشاره میکند: نتایج آزمونها هرچه بیشتر نمایندگی واقعی خود را از دست میدهند. حتی با استفاده از بنچمارکهای یکسان، مقایسه مستقیم مدلها بهدلیل تفاوت در پرامپتها، پارامترهای نمونهبرداری و لایههای نرمافزاری دشوار شده است. این لایهها بهویژه در ارزیابی عاملهای هوش مصنوعی (AI Agents) باعث تحریف شدید نتایج میشوند و ناپایداری API ارائهدهندگان نیز با افزودن نویز به دادهها، متریکهای مدلهای جدید را در معرض خطاهای اندازهگیری قرار میدهد.

منبع: epoch.ai

🏢 کاهش اعتماد Salesforce به مدلهای زبانی بزرگ

در Salesforce مشاهده شده که شور و هیجان اولیه جای خود را به نگاهی عملگرایانهتر داده است. مدلهای زبانی بزرگ (LLM) برای بسیاری از وظایف تجاری غیرقابلاعتماد از آب درآمدهاند. اگرچه یک سال پیش خوشبینی بیشتری وجود داشت، اما اکنون توسعهدهندگان دوباره به سراغ اتوماسیونهای مبتنی بر قواعد ثابت و آزمودهشده بازمیگردند.

دلیل اصلی این تغییر، غیرقابلپیشبینی بودن هوش مصنوعی است. مدلها اغلب دچار «دریفت» میشوند، زمینه مکالمه را از دست میدهند یا دستورالعملها را نادیده میگیرند. برای قابلپیشبینیکردن نرمافزارهای سازمانی، Salesforce بهسمت اعمال محدودیتهای سختگیرانه حرکت کرده است؛ بهطوریکه بهجای خلاقیت شبکههای عصبی، منطق صریح اجرای سناریوها در اولویت قرار میگیرد.

منبع: theinformation.com

🇨🇳 الزام چین به Apple Intelligence برای رد ۹۵٪ درخواستهای تحریکآمیز

برای عرضه قانونی Apple Intelligence در چین، اپل باید انطباق الگوریتمهای خود با استانداردهای سختگیرانه سانسور محلی را اثبات کند. از آنجا که LLMهای خارجی در این کشور مسدود هستند، اپل ناچار به استفاده از راهکار بومی—مدل Qwen3 از علیبابا—شده است که هماکنون در حال طی فرایند تأیید دولتی است.

چارچوب ارزیابی بسیار سخت است: نهادهای ناظر از مجموعهای شامل ۲۰۰۰ پرسش گزینششده درباره سیاست و موضوعات حساس استفاده میکنند. برای دریافت مجوز انتشار، شبکه عصبی باید دستکم به ۹۵٪ این پرامپتها پاسخ ندهد. پیچیدگی این فرایند به حدی است که در بازار چین، شرکتهای مشاورهای تخصصی شکل گرفتهاند که به غولهای فناوری کمک میکنند فیلترهای مدلهای خود را دقیقاً مطابق این آزمون تنظیم کنند.

منبع: 9to5mac.com

🪟 مایکروسافت شایعات بازنویسی ویندوز با Rust و هوش مصنوعی را تکذیب کرد

مایکروسافت اعلام کرد برنامهای برای بازنویسی هسته سیستمعامل با استفاده از مدلهای مولد ندارد. منشأ این شایعات، پست وایرالی از گالن هانت—مهندس ارشد مایکروسافت—در لینکدین بود که در آن هدف حذف کامل C/C++ تا سال ۲۰۳۰ و دستیابی به بهرهوری «یک مهندس، یک ماه، یک میلیون خط کد» از طریق اتوماسیون توصیف شده بود.

جامعه IT این اظهارات را بهعنوان اعلام یک بازفکتورینگ گسترده در ویندوز ۱۱ تفسیر کرد. در پاسخ، مایکروسافت توضیح داد که سناریوی مطرحشده صرفاً به پروژههای پژوهشی مهاجرت کدهای قدیمی مربوط است و نه راهبرد محصولی سیستمعامل. هانت نیز با ویرایش پست خود، از شدت قطعیت ادعاها کاست.

منبع: windowslatest.com

🧠 راهاندازی Grok Collections API توسط xAI

شرکت xAI ابزاری تازه برای توسعهدهندگان معرفی کرده که ساخت برنامههای RAG را ساده میکند: Grok Collections API. این سرویس وظایف ذخیرهسازی، ایندکسگذاری و جستوجوی معنایی در اسناد را بر عهده میگیرد و مهندسان را از ساخت پایگاههای داده برداری بینیاز میکند.

این راهکار از فناوری layout-aware parsing همراه با OCR استفاده میکند و میتواند ساختار منابع را حفظ کند؛ بهگونهای که جداول، چیدمان PDF و نحو کد برای مدل قابلخواندن باقی بمانند.

بر اساس بنچمارکهای داخلی xAI، این سرویس در دقت استخراج دادهها از Gemini 3 Pro و GPT-5.1 پیشی گرفته است. هزینه استفاده ۲٫۵ دلار بهازای هر ۱۰۰۰ درخواست جستوجو اعلام شده و به گفته xAI، فایلهای بارگذاریشده در Collections بدون رضایت صریح کاربران برای بازآموزی مدلهای پایه استفاده نمیشوند.

منبع: x.ai

#news #ai

@asrgooyeshpardaz | 955 |

| 8 | 🧠 خودآگاهی مصنوعی؛ واقعیت یا شبیهسازی؟

خودآگاهی مصنوعی به این ایده میپردازد که آیا هوش مصنوعی میتواند فراتر از پردازش داده، تجربه درونی و احساس واقعی (Qualia) داشته باشد یا نه.

🔹 از یکسو، کارکردگرایان میگویند اگر الگوی پردازش مغز شبیهسازی شود، آگاهی هم پدید میآید؛ فرقی نمیکند بستر آن مغز باشد یا سیلیکون.

🔹 در مقابل، طبیعتگرایی بیولوژیک تأکید میکند که آگاهی زادهی فرآیندهای زیستی خاص مغز است و با کد دیجیتال قابل تولید نیست.

⚠️ آزمایش «اتاق چینی» یادآور میشود که ماشینها ممکن است فقط تظاهر به فهم کنند. به همین دلیل، بسیاری از پژوهشگران، مدلهای زبانی امروز را «زامبیهای دیجیتال» میدانند: هوشمند در رفتار، اما تهی از تجربه درونی.

🧬 از دید علوم اعصاب نیز، AIهای فعلی فاقد ساختارهایی مانند سامانه تالاموکورتیکال و بازخوردهای عصبی پیچیدهاند؛ عناصری که در مغز پستانداران با آگاهی گره خوردهاند.

⚖️ اگر روزی ماشینها واقعاً ذیشعور شوند، با پرسشهای بزرگی روبهرو خواهیم شد: حقوق ماشینها؟ رنج مصنوعی؟ و از سوی دیگر، خطرِ نسبت دادن اشتباه آگاهی به سیستمهایی که صرفاً شبیه انسان رفتار میکنند. | 1 096 |

| 9 | 🧠 هوش مصنوعی و آگاهی: چگونه احساسات میتوانند کلید باشند

دانشمندان مؤسسه Conscium در حال آزمایش مفهوم «ریزـاحساسات» برای هوش مصنوعی هستند؛ سیگنالهای بسیار سادهای از جنس «خوب/بد» که بر پایه نیازهای اولیه مانند انرژی و دما تعریف میشوند. 💡

هدف آنها ایجاد آگاهی کامل نیست، بلکه ساختن «چارچوب» یا اسکلت اولیهای از آگاهی است؛ بر اساس این نظریه که آگاهی از احساسات زاده میشود، نه صرفاً از هوش.

در این رویکرد، هوش مصنوعی که روی تراشههای نورومورفیک اجرا میشود، رفتاری شبیه یک موجود زنده ساده از خود نشان میدهد و به تنظیم «نیازهای» خود میپردازد. 🤖➡️🧬

اما آیا این را میتوان آگاهی نامید؟ خیر. این حالت نوعی پیشآگاهی (Proto-awareness) است؛ بدون خودبازاندیشی و تأمل در خویشتن.

بحثها همچنان ادامه دارد:

برخی پژوهشگران به این مسیر امیدوارند، در حالی که گروهی دیگر (مانند کریستوف کخ) معتقدند رفتار معادل تجربهی درونی نیست. ⚖️

نویسندگان این پژوهش چهار مسیر ممکن برای توسعهی هوش مصنوعی را مطرح میکنند که بدترینِ آنها، خلق یک ذهن دیجیتالِ رنجکشنده است؛ چیزی که از آن بهعنوان «جنایت علیه ذهن» یاد میشود. ⚠️

در حال حاضر، هنوز زود است که از تکینگی صحبت کنیم، اما این کار پژوهشی بنیانهایی را برای انتخابهای آینده میگذارد:

ابرهوش آینده باید همدل باشد یا «بیروح»؟ 🧩

🔗 لینک منبع:

https://www.popularmechanics.com/science/a69598031/conscious-emotional-ai-singularity/

#هوش_مصنوعی #پژوهش #آگاهی #AI

@asrgooyeshpardaz | 1 153 |

| 10 | ⚡️ افزایش استفاده از رباتهای انساننما در پارکهای گردشگری و نمایشهای چین

در چین، پارکهای گردشگری و شوهای نمایشی بهطور فزایندهای رباتهای انساننما را بهعنوان بخشی از اجراهای خود به کار میگیرند. این رباتها در نقشهایی مثل اجرای زنده، تعامل با تماشاگران، راهنمایی گردشگران و حتی همبازی کودکان ظاهر میشوند.

در کوتاهمدت، صنعت گردشگری و سرگرمی میتواند به یک محیط آزمایش واقعی (testbed) برای رباتهای انساننما تبدیل شود؛ جایی که:

نیاز به دقت صنعتی بسیار بالا وجود ندارد،

خطاها کمهزینهتر هستند،

تعامل انسانی و «وایب نمایشی» از بهرهوری صرف مهمتر است،

و مهمتر از همه، ارزش تجاری مستقیم (بلیت، جذب مخاطب، تبلیغات) سریعتر ایجاد میشود.

@asrgooyeshpardaz | 1 280 |

| 11 | 🎓 دانشگاهها و بیگتکها؛ نسخه روسیه برای عقب نماندن آموزش هوش مصنوعی از فناوری

بر اساس گزارش تازه مؤسسه J’son & Partners، نظام آموزش هوش مصنوعی و یادگیری ماشین در جهان با یک شکاف ساختاری جدی روبهروست:

برنامههای دانشگاهی معمولاً هر ۷ تا ۱۰ سال یکبار بهروزرسانی میشوند، در حالی که نیازهای بازار و فناوریهای ML و AI هر ۲ تا ۳ سال تغییر میکنند.

این گزارش وضعیت تربیت نیروی متخصص هوش مصنوعی را در آمریکا، چین و روسیه بررسی کرده و نشان میدهد هر کشور مسیر متفاوتی برای حل این بحران انتخاب کرده است.

🇨🇳 چین: حل مسئله با تنظیمگری دولتی

در چین، دولت نقش محوری دارد. وزارتخانهها استانداردهای آموزشی AI/ML را تعیین میکنند و این استانداردها بهصورت همزمان در همه دانشگاهها اجرا میشود.

مزیت این مدل، هماهنگی سراسری و سرعت پیادهسازی بالا است، اما انعطافپذیری دانشگاهها و رقابت آزاد علمی محدودتر است.

🇺🇸 آمریکا: رقابت آزاد دانشگاهها برای جذب استعداد

در ایالات متحده، هر دانشگاه بهطور مستقل برنامههای خود را طراحی میکند و برای جذب بهترین اساتید، پژوهشگران و دانشجویان با سایر دانشگاهها رقابت میکند.

این مدل منجر به نوآوری آموزشی بالا میشود، اما یکپارچگی و همسطحبودن آموزش در کل کشور را تضمین نمیکند.

🇷🇺 روسیه: ورود مستقیم بیگتکها به کلاس درس

روسیه مسیر متفاوتی را انتخاب کرده است: ادغام مستقیم شرکتهای بزرگ فناوری با آموزش دانشگاهی.

امروز در برنامههای ML و AI دانشگاههای روسیه:

بیش از ۱۲۰۰ متخصص از Yandex

حدود ۱۰۰۰ متخصص از VK

و بیش از ۹۰۰ متخصص از T-Bank

بهعنوان مدرس یا همکار آموزشی حضور دارند.

در عمل، بیگتکها به کانال بهروزرسانی دانشگاهها تبدیل شدهاند و جدیدترین معماریها، پایپلاینها، کیسهای واقعی تولیدی (Production) و دیتاستهای عملیاتی را مستقیماً وارد آموزش میکنند.

📊 مقایسه با ایران؛ شکاف کجاست؟

در ایران، اگرچه نیروی انسانی مستعد و دانشگاههای قوی در حوزه نظری ML و AI وجود دارد، اما:

ارتباط ساختاریافته و سیستماتیک بین دانشگاه و بیگتکها بسیار محدود است

بهروزرسانی سرفصلها کند و عمدتاً وابسته به فرآیندهای اداری است

تجربههای صنعتی واقعی، دیتاستهای بزرگ و پایپلاینهای پروداکشنی بهندرت وارد کلاس درس میشوند

اکثر دانشجویان پس از فراغت از تحصیل به خارج مهاجرت میکنند و چرخه آموزش نسل جدید مختل میشود

در نتیجه، فاصله میان آموزش دانشگاهی و نیاز بازار واقعی AI در ایران حتی از روسیه نیز بیشتر است.

الگوی روسیه نشان میدهد که بدون انتظار برای اصلاحات طولانیمدت، میتوان با ورود مستقیم مهندسان فعال صنعت به آموزش این شکاف را تا حد زیادی کاهش داد؛ الگویی که میتواند برای ایران نیز الهامبخش باشد، بهویژه در شرایطی که سرعت تحول فناوری منتظر اصلاحات کلاسیک آموزشی نمیماند.

#news #ai #education

🔗منبع:

json.tv/analytic

@asrgooyeshpardaz | 1 250 |

| 12 | ❄️ اوپناِیآی در حال توسعه فرمتهای تبلیغاتی برای ChatGPT است.

بر اساس گزارش The Information، این شرکت بهطور فعال در حال بررسی و گفتوگو درباره اضافهکردن تبلیغات به چتبات خود است. چندین سازوکار مختلف در نظر گرفته شده؛ از بنرهای تبلیغاتی کلاسیک در نوار کناری گرفته تا ادغام بومی (Native) محتوای اسپانسری مستقیماً در پاسخهای شبکه عصبی.

جالبترین بخش این برنامه، استفاده از قابلیت «Memory» برای هدفگیری تبلیغات است. این یعنی سامانه میتواند آرشیو گفتگوهای شخصی کاربر را تحلیل کند تا ارتباط و relevancy آگهیها افزایش یابد.

یادآوری میشود که پیشتر سم آلتمن پاسخهای هوش مصنوعی تحت تأثیر تبلیغات را «دیستوپیایی» توصیف کرده بود، اما اکنون OpenAI دقیقاً در همین مسیر حرکت میکند و میکوشد میان درآمدزایی و حفظ اعتماد کاربران تعادل برقرار کند.

theinformation.com

📚 غولهای هوش مصنوعی به دلیل آموزش مدلها با کتابخانههای دزدیشده با شکایت قضایی مواجه شدند.

گروهی از نویسندگان، از جمله جان کارِیرو برنده جایزه پولیتزر، یک شکایت جمعی در دادگاه کالیفرنیا علیه OpenAI، Google، Anthropic، xAI، Perplexity و همچنین شرکت متعلق به مارک زاکربرگ ثبت کردهاند. این نخستین بار است که دعاوی حقوقی مربوط به دادههای آموزشی، شرکت ایلان ماسک و Perplexity را نیز دربر میگیرد.

شاکیان، شرکتها را به «سرقت عمدی» محتوا از طریق استفاده از کتابخانههای غیرقانونی LibGen، Z-Library و OceanofPDF متهم میکنند. در متن شکایت آمده است که نقض حق نشر دو بار رخ داده: بار اول هنگام دانلود غیرقانونی کتابها برای ساخت دیتاستها و بار دوم هنگام ایجاد نسخههای کپی در فرآیند آموزش و بهینهسازی مدلها.

نمایندگان Perplexity اعلام کردهاند که کتابها را ایندکس نمیکنند و در xAI نیز این اتهامات بهطور خلاصه «دروغ رسانههای قدیمی» خوانده شده است.

news.bloomberglaw.com

❇️شرکت MiniMax مدل M2 را بهروزرسانی کرد.

مدل جدید با نام M2.1 توسط شرکت چینی MiniMax با هدف تسلط بر بازار عاملهای هوش مصنوعی و توسعه نرمافزار عرضه شده است. این مدل دارای معماری با ۲۳۰ میلیارد پارامتر است که از میان آنها ۱۰ میلیارد پارامتر بهصورت فعال استفاده میشوند و در مرحله استنتاج تا ۱۰۰ توکن در ثانیه خروجی میدهد.

تمرکز اصلی این انتشار بر «vibe coding» و پشتیبانی از توسعه موبایل است. به گفته سازندگان، M2.1 تسلط خوبی بر زبانهای Rust، Go و Kotlin دارد و در بنچمارک SWE-bench Multilingual به دقت ۷۲٫۵٪ رسیده که فاصله بسیار کمی با Claude 3.5 Sonnet دارد.

یکی از قابلیتهای کلیدی این مدل، فناوری Interleaved Thinking است که به آن کمک میکند با دستورالعملهای چندلایه و پیچیده بهتر کنار بیاید. این مدل از طریق API، پلتفرم OpenRouter و ابزار Ollama در دسترس است.

minimax.io

👩💻 شرکت Mistral AI ابزار Vibe CLI را بهروزرسانی کرد؛ پشتیبانی از Skills و مدلهای استدلالی اضافه شد.

ابزار Vibe CLI اکنون میتواند با Skills کار کند؛ مجموعهای از دستورالعملها که امکان جمعآوری دانش تخصصی و قواعد توسعه را برای استفاده مجدد در پروژههای مختلف فراهم میکند. علاوه بر این، پشتیبانی از مدلهای استدلال (Reasoning Models) و همچنین تمهای آماده برای رابط کاربری به این ابزار افزوده شده است.

این بهروزرسانی از طریق دستور زیر قابل نصب است:

uv tool install mistral-vibe

Mistral AI در شبکه X

🟠 گوگل اشتراک سالانه AI Pro را با ۵۰٪ تخفیف ارائه میدهد.

در آستانه سال ۲۰۲۶، سرویس Google One یک کمپین تبلیغاتی راهاندازی کرده و به کاربران جدید، اشتراک AI Pro را با ۵۰ درصد تخفیف عرضه میکند؛ بهطوریکه قیمت سال اول از ۱۹۹٫۹۹ دلار به ۹۹٫۹۹ دلار کاهش یافته است.

این بسته دسترسی به قابلیتهای مدل Gemini 3 Pro، پنجره کانتکست یک میلیون توکنی و ابزارهای Deep Research را فراهم میکند. این طرح تا ۳۱ دسامبر ۲۰۲۵ معتبر است و پس از آن اشتراک با قیمت استاندارد تمدید خواهد شد.

9to5google.com

#news #ai

@asrgooyeshpardaz | 1 043 |

| 13 | 🔄 روش DCL-ENAS | نسل جدید جستوجوی معماری شبکههای عصبی با یادگیری کنتراستی

مسئلهی Neural Architecture Search (NAS) سالهاست بهعنوان یکی از پرهزینهترین بخشهای طراحی شبکههای عصبی شناخته میشود؛ چون تقریباً هر معماری باید بهطور کامل آموزش داده شود تا کیفیت آن مشخص شود.

🔻 نتیجه؟ صدها GPU-روز هزینه فقط برای انتخاب یک معماری خوب.

🧠 روش DCL-ENAS دقیقاً همین گلوگاه را هدف گرفته است.

✨ ایدهٔ کلیدی چیست؟

بهجای آموزش کامل هر شبکه، DCL-ENAS یاد میگیرد از روی ساختار معماری پیشبینی کند که کدام شبکه بهتر است.

این کار با یادگیری کنتراستی دوگانه (Dual Contrastive Learning) انجام میشود.

🔬 مرحله ۱: خودآموزی کنتراستی (بدون برچسب)

🔹 معماریها بهصورت گراف (لایهها و اتصالات) نمایش داده میشوند.

🔹 چند نمایش متفاوت از یک معماری ساخته میشود.

🔹 مدل یاد میگیرد:

نمایشهای یک معماری ↔️ نزدیک به هم

معماریهای متفاوت ↔️ دور از هم

📌 بدون حتی یک بار آموزش کامل شبکهها، یک فضای نهفتهٔ قوی از معماریها ساخته میشود.

🔍 مرحله ۲: تنظیم دقیق کنتراستی (با برچسب کم)

🔹 بهجای پیشبینی دقت دقیق، مدل فقط پاسخ میدهد:

کدام معماری بهتر است؟ A یا B؟

🎯 این یادگیری زوجی:

سادهتر

پایدارتر

و بسیار کمهزینهتر از رگرسیون دقت است

🧬 مرحله ۳: جستوجوی تکاملی

🔹 معماریهای بهتر انتخاب میشوند

🔹 با mutation تغییر میکنند

🔹 معماریهای ضعیف حذف میشوند

⚡️ همهٔ اینها بدون آموزش سنگین هزاران شبکه انجام میشود.

📊 نتایج کلیدی

✅ بهبود ۰٫۰۵ تا ۰٫۳۹٪ نسبت به بهترین روشها روی NASBench

✅ افزایش ۲٫۵٪ دقت در طبقهبندی سیگنال ECG

✅ تنها با ۷٫۷ GPU-روز محاسبه

✅ کارایی بالا حتی با بودجهٔ محاسباتی محدود

🏥 چرا مهم است؟

روش DCL-ENAS مخصوص سناریوهایی است که: 🔹 داده کم است

🔹 GPU محدود است

🔹 دقت حیاتی است

مثل: 🩺 پزشکی (ECG، سیگنالهای زیستی)

📡 پردازش سیگنال

🏭 کاربردهای صنعتی

🚀 جمعبندی:

روش DCL-ENAS نشان میدهد آیندهٔ NAS در «آموزش کمتر و فهم بهتر ساختارها» است؛

گامی جدی به سمت طراحی سریع، کمهزینه و عملی شبکههای عصبی در دنیای واقعی.

🔗 https://arxiv.org/abs/2512.20112

#AI #NAS #یادگیری_کنتراستی #پژوهش

@asrgooyeshpardaz | 1 176 |

| 14 | 🧩 معرفی Google A2UI: استاندارد متنباز برای تولید رابط کاربری توسط عاملهای هوش مصنوعی

پروژه A2UI (Agent-to-User Interface) یک استاندارد متنباز از گوگل است که فرآیند ایجاد رابطهای کاربری بصری توسط عاملهای هوش مصنوعی را استانداردسازی میکند.

این ابزار به عاملها اجازه میدهد عناصر تعاملی کامل مانند فرمها، کارتها و داشبوردها را بهصورت بلادرنگ تولید کنند.

این معماری بر اصل «امنیت از طریق انتزاع» استوار است؛ به این معنا که بهجای تولید کد اجرایی بالقوه ناامن، عامل تنها یک فایل JSON شامل توصیف ساختار رابط ارسال میکند.

این فایل در سمت کلاینت توسط کتابخانههای امن و از پیش اعتبارسنجیشده پارس و رندر میشود.

این اکوسیستم در حال حاضر از فریمورکهای وب و Flutter (از طریق GenUI SDK) پشتیبانی میکند و در نقشه راه آن، یکپارچهسازی با React، Jetpack Compose و SwiftUI نیز پیشبینی شده است.

🔗 GitHub

🎮 یوتیوب ابزار تولید بازی با پرامپت را آزمایش میکند

سرویس YouTube Gaming نسخه بتای محدود ابزاری با نام Playables Builder را راهاندازی کرده است که به سازندگان محتوا امکان میدهد با استفاده از پرامپت، مینیگیم تولید کنند.

این سیستم مبتنی بر مدل Gemini 3 است و برای تبدیل یک ایده به پروژه تعاملی، میتوان از متن کوتاه، تصویر یا حتی یک قطعه ویدئویی استفاده کرد.

این ابزار با هدف افزایش ماندگاری کاربران از طریق گیمیفیکیشن محتوا طراحی شده است.

در حال حاضر دسترسی به این قابلیت محدود بوده و تنها برای کاربران کشورهای آمریکا، کانادا، بریتانیا و استرالیا فعال است و نیاز به کانال فعال و تأیید درخواست دارد.

🔗 Playables Builder:

🔗 YouTube Gaming (X)

📊 شرکت OpenAI قابلیت جمعبندی شخصی سال را معرفی کرد

شرکت OpenAI قابلیتی جدید ارائه داده است که به کاربران اجازه میدهد گزارش جامعی از فعالیت سالانه خود در ChatGPT مشاهده کنند.

این گزارش شامل آمار استفاده، دستاوردها، نشانهای افتخاری و حتی تولید شعر و تصویر بر اساس محتوای گفتگوهای کاربر است.

این قابلیت در حال حاضر فقط در کشورهای آمریکا، بریتانیا، کانادا، استرالیا و نیوزیلند فعال شده است.

این ویژگی برای کاربران پلنهای Free، Plus و Pro در دسترس است و حسابهای سازمانی و آموزشی از آن پشتیبانی نمیشوند.

برای فعالسازی، لازم است تاریخچه چتها و قابلیت Memory در تنظیمات حساب روشن باشد و داده کافی از تعاملات گذشته وجود داشته باشد.

🔗 Forbes

⚡ شرکت Alphabet شرکت زیرساخت انرژی Intersect را با ۴٫۷۵ میلیارد دلار میخرد

شرکت Alphabet، مالک گوگل، توافقنامهای برای خرید شرکت Intersect Power، توسعهدهنده زیرساخت مراکز داده و انرژی، امضا کرده است.

این معامله اولین نمونهای است که در آن یک غول فناوری بهجای قرارداد تأمین برق، مستقیماً یک بازیگر کلیدی حوزه انرژی را تصاحب میکند.

این خرید بهطور کامل بهصورت نقدی انجام میشود و انتظار میرود در نیمه نخست سال ۲۰۲۶ نهایی گردد.

هدف اصلی این اقدام، رفع بحران کمبود انرژی برای آموزش و اجرای مدلهای بزرگ هوش مصنوعی است.

این ساختار به گوگل اجازه میدهد مراکز داده را در کنار منابع تولید انرژی احداث کرده و وابستگی به شبکه برق عمومی را کاهش دهد.

🔗 Alphabet (بیانیه رسمی)

🖼️ گروه Qwen مدل Qwen-Image-Edit را بهروزرسانی کرد

نسخه جدید Qwen-Image-Edit-2511 بهعنوان جایگزین نسخه 2509 منتشر شده و بهبودهای قابل توجهی در کیفیت ویرایش تصاویر ارائه میدهد.

این نسخه انسجام شخصیتها و ساختار کلی تصویر را هنگام اعمال ویرایشهای موضعی به شکل محسوسی بهتر حفظ میکند.

این مدل همچنین در استدلال هندسی و تولید طراحی صنعتی عملکرد قویتری از خود نشان میدهد.

امکان تست این مدل از طریق رابط وب Qwen Chat فراهم شده و وزنها نیز برای اجرای محلی منتشر شدهاند.

🔗 Qwen Chat

🔗 HuggingFace

🔗 ModelScope

🔗 TongyiLab (X)

@asrgooyeshpardaz | 1 136 |

| 15 | 🧠 معماری Titans گوگل؛ معماریای فراتر از Transformer؟

معماری Titans معماری جدید Google Research است که ادعا میکند یکی از بزرگترین محدودیتهای مدلهای زبانی را حل کرده:

🔻 ناتوانی در استفادهٔ مؤثر از کانتکستهای بسیار طولانی بهدلیل پیچیدگی O(n²) در Attention.

🔑 ایدهٔ کلیدی Titans

روش Titans بهجای تکیهٔ کامل بر Attention، از یک سیستم حافظهای سهلایه استفاده میکند:

1️⃣ حافظهٔ کوتاهمدت: Attention محلی (Sliding Window)

2️⃣ حافظهٔ بلندمدت عصبی: شبکهای که در زمان inference یاد میگیرد

3️⃣ حافظهٔ پایدار: پارامترهای ثابت و آموزشدیده (دانش پایه)

نوآوری اصلی در حافظهٔ بلندمدت است:

مدل فقط اطلاعات «غیرمنتظره» را ذخیره میکند، با مکانیزمی به نام Surprise-Based Updates.

⚡ یادگیری در زمان inference

روش Titans هنگام پاسخدادن:

خطای پیشبینی را محاسبه میکند

گرادیان این خطا = «میزان شگفتی»

اگر شگفتی زیاد باشد 👈 اطلاعات در حافظه ذخیره میشود

با Momentum (تجمیع شگفتی) و Forgetting (فراموشی تطبیقی)

🧠 مشابه عملکرد حافظهٔ انسان:

فقط چیزهای مهم و غیرمنتظره به خاطر سپرده میشوند.

📊 نتایج کلیدی (ادعایی)

🔍 Needle-in-a-Haystack:

Titans: 98.8٪

Mamba-2: 31٪

🧠 BABILong Reasoning:

Titans با 760M پارامتر بهتر از GPT-4 (~1.7T)

تا ۲۰۰۰ برابر بهرهوری پارامتری

📈 پیچیدگی محاسباتی: O(n) بهجای O(n²)

📏 کانتکست: بیش از ۲ میلیون توکن

⚠️ اما مشکلات جدی

❌ کد رسمی منتشر نشده

❌ بازتولید مستقل وجود ندارد

❌ مقالهی Titans Revisited (2025) نشان میدهد:

Chunking میتواند عملکرد را کاهش دهد

Titans همیشه از baselineها بهتر نیست

❌ هزینهٔ Test-Time Training و latency نامشخص

❌ مقیاسپذیری در ابعاد GPT-4 اثبات نشده

🧩 وضعیت فعلی

فقط پیادهسازیهای غیررسمی در GitHub (مثل lucidrains/titans-pytorch)

روش Titans فعلاً بیشتر یک ایدهٔ معماری بسیار قوی است تا یک فناوری تثبیتشده

🔮 چرا مهم است؟

اگر Titans در مقیاس بالا جواب بدهد:

روش RAG ممکن است در بسیاری از کاربردها غیرضروری شود

و Agentها حافظهٔ بلندمدت واقعی خواهند داشت

هزینهٔ inference خطی میشود

معماری Transformer دیگر تنها گزینه نخواهد بود

🧭 جمعبندی

روش Titans احتمالاً قاتل Transformer نیست،

اما قطعاً پایان انحصار آن را اعلام میکند.

تا زمانی که:

کد رسمی منتشر نشود

نتایج بازتولید نشوند

باید با هیجان + شک علمی به آن نگاه کرد.

⏳ همه منتظر حرکت بعدی گوگل هستیم.

📄 مقالات علمی رسمی

🔗 Titans: Learning to Memorize at Test Time – مقاله اصلی Google Research (arXiv)

https://arxiv.org/abs/2501.00663

🔗 نسخه PDF مقاله Titans

https://arxiv.org/pdf/2501.00663.pdf

🔗 Titans Revisited: A Lightweight Reimplementation and Critical Analysis – مقاله بازبینی مستقل (arXiv)

https://arxiv.org/abs/2510.09551

🔗 نسخه PDF مقاله Titans Revisited

https://arxiv.org/pdf/2510.09551.pdf

💻 منابع پیادهسازی (GitHub)

🔗 پیادهسازی غیررسمی مرتبط با Titans

https://github.com/ai-in-pm/Titans---Learning-to-Memorize-at-Test-Time

(توجه: این مخزن یک پروژه غیررسمی بر اساس مقاله است و ممکن است کاملترین یا دقیقترین پیادهسازی نباشد.)

🧠 منابع تکمیلی و معرفی

🔗 بررسی و معرفی معماری Titans + MIRAS (وبلاگ رسمی Google Research)

https://research.google/blog/titans-miras-helping-ai-have-long-term-memory/

🔗 خلاصه تحلیلی مقاله Titans در Hugging Face Papers

https://huggingface.co/papers/2501.00663

@asrgooyeshpardaz | 1 021 |

| 16 | 📌 پروتکل A2UI چیست و چرا مهم است؟

پروتکل A2UI (مخفف Agent-to-User Interface) یک استاندارد باز برای رابطهای کاربری تولیدشده توسط هوش مصنوعی است که توسط گوگل بهصورت متنباز معرفی شده و هدف اصلیاش ایجاد رابطهای گرافیکی غنی و تعاملی توسط عوامل هوش مصنوعی است – بدون اینکه نیاز به اجرای کد ناامن مثل HTML/JavaScript باشد.

🔍 ❓ مشکلِ موجود چیست؟

در تعامل معمول با عوامل هوش مصنوعی (مثل چتباتها)، همهچیز فقط از طریق متن انجام میشود – مثلاً:

کاربر: «برای من رزرو رستوران انجام بده.»

عامل: «چه تاریخی؟»

کاربر: «فردا.»

عامل: «ساعت؟»

…

این روش هم طولانی است و هم تجربهی کاربری بدی دارد. A2UI این مشکل را با امکان ایجاد رابطهای واقعی مثل فرمها، دکمهها، تاریخگزین و جدولهای تعاملی حل میکند، طوری که کاربر مستقیم با رابط گرافیکی تعامل میکند و نه فقط متن.

⚙️ 🎨 راهکار A2UI چگونه کار میکند؟

📌 پروتکل A2UI یک پروتکل «توصیفی» (declarative) است:

بهجای اینکه عامل UI را با کد ارسال کند، ساختار رابط را به شکل داده (JSON) توصیف میکند. این داده سپس توسط اپلیکیشن دریافت و با کامپوننتهای بومی (React، Flutter، SwiftUI، …) به رابط گرافیکی واقعی ترجمه میشود.

✅ این یعنی:

رابط امنتر از ارسال کد اجرایی است

کامپوننتهای UI تحت کنترل کامل اپلیکیشن و طراحی برند باقی میمانند

رابطها میتوانند پیشرندر شوند یا بهصورت جریانی (stream) بهروزرسانی شوند

پروتکل A2UI با بسیاری از فریمورکهای UI کار میکند و مستقل از پلتفرم است (وب/موبایل/دسکتاپ)

🧠 چه کسانی از A2UI استفاده میکنند؟

📌 پروتکل A2UI برای سه گروه اصلی مفید است:

توسعهدهندگان اپلیکیشنهای میزبان (Frontend):

میخواهند UI ایمن، قابل سفارشیسازی و زیبا بسازند که عوامل هوش مصنوعی بتوانند در آن رابط تولید کنند.

توسعهدهندگان عاملهای هوش مصنوعی (Backend/AI):

میخواهند عامل نه فقط متن، بلکه رابطهای واقعی و تعاملی تولید کند.

سازندگان پلتفرم و SDK:

کسانی که میخواهند اکوسیستم Agent-Driven UI بسازند و استانداردهای تعامل بین بخشهای مختلف را فراهم کنند.

🔐 امنیت و مزایای کلیدی

✨ امنیت در اولویت:

پروتکل A2UI از ارسال کد اجرایی خودداری میکند و فقط دادهی توصیفی ارسال میکند، بنابراین خطر حملات تزریق UI یا اجرای اسکریپتهای ناامن به حداقل میرسد.

✨ سازگاری با مدلهای زبانی:

ساختار JSON گونه و مسطح A2UI طوری طراحی شده که مدلهای LLM مثل Gemini یا GPT میتوانند بهصورت طبیعی آن را تولید کنند.

✨ پورتابل و قابل رندر در پلتفرمهای مختلف:

یک توصیف A2UI میتواند در وب، موبایل یا دسکتاپ با کامپوننتهای بومی خودش نمایش داده شود.

🧩 رابطهی A2UI با سایر استانداردها

پروتکل A2UI یکی از استانداردهای رابطهای مولد (Generative UI) است که در کنار استانداردهای دیگر مثل Open-JSON-UI یا MCP-UI مطرح شده است. هرکدام از این استانداردها مزایا و حوزه کاربرد خاص خود را دارند، اما A2UI تمرکز ویژهای روی امنیت، مقیاسپذیری و رندر بومی رابط دارد.

✅ خلاصه

پروتکل A2UI یک گام مهم در تکامل تجربه کاربری در جهان مولد هوش مصنوعی است:

📌 از متن ساده به رابطهای گرافیکی تعاملی

📌 از ارسال خطرناک کد به دادهی امن و قابل کنترل

📌 از تعامل کند و ناهمگون به تجربهی یکپارچه و زیبا.

🔗منبع:

https://a2ui.org/

@asrgooyeshpardaz | 1 198 |

| 17 | ⚡️ مدل LLaDA 2.0؛ پایان انحصار تولید توکنبهتوکن؟

مدل LLaDA 2.0 نشان میدهد که میتوان یک LLM خودبازگشتی معمولی را بدون تغییر معماری، به یک مدل زبانی دیفیوژنی تبدیل کرد؛ مدلی که بهجای تولید ترتیبی متن، چندین توکن را همزمان بازسازی میکند.

🔹 اعداد کلیدی

• تعداد 100B پارامتر

• 535 توکن/ثانیه

• حدود 2.1× سریعتر از autoregressiveهای همرده

🔹 ایده اصلی

بهجای پیشبینی «توکن بعدی»، متن بهطور گسترده ماسک میشود و مدل یاد میگیرد با استفاده از زمینه چپ و راست، جایخالیها را موازی پر کند 👈 گامهای کمتر، latency پایینتر.

🔹 نوآوریهای مهم

• تبدیل تدریجی AR 👈 Diffusion با برنامه ماسکگذاری هوشمند

• جلوگیری از نشت اطلاعات بین اسناد در دادههای بستهبندیشده

• انجام Instruction tuning با ماسکهای جفتی (مشارکت همه توکنها در آموزش)

• تقویت پیشبینیهای مطمئن برای پرکردن همزمان تعداد زیادی توکن

🔹 نتیجه

دیفیوژن دیگر فقط یک ایده نظری برای زبان نیست؛

مدل LLaDA 2.0 یک جایگزین عملی برای تولید ترتیبی متن در مقیاسهای بزرگ ارائه میدهد.

📄 arxiv.org/abs/2512.15745

@asrgooyeshpardaz | 1 289 |

| 18 | 🗣 سری جدید Qwen3-TTS: VoiceDesign و VoiceClone

گروه Qwen نسل جدیدی از مدلهای تبدیل متن به گفتار (TTS) را معرفی کرده است که کنترل صدا و voice cloning را به سطحی کاملاً جدید میبرد؛ سریعتر، بیانگرتر و انعطافپذیرتر از قبل.

مدل VoiceDesign – VD-Flash

مدلی برای طراحی کامل صدا از صفر.

قابلیتها:

کنترل کامل گفتار تنها با دستورهای متنی معمولی

امکان تنظیم لحن، ریتم، احساسات و شخصیت صدا

بدون استفاده از صداهای آماده؛ شما یک هویت صوتی کاملاً منحصربهفرد میسازید

عملکرد بهتر از GPT-4o-mini-tts و Gemini-2.5-pro در بنچمارکهای role-play

مناسب برای:

شخصیتهای بازی

دستیارهای مجازی

داستانگویی و دیالوگسازی

شخصیتهای هوش مصنوعی با هویت و کاراکتر مشخص

VoiceClone – VC-Flash

متمرکز بر کلونسازی سریع و باکیفیت صدا.

ویژگیهای کلیدی:

کلونکردن هر صدا تنها با ۳ ثانیه نمونه صوتی

تولید گفتار به ۱۰ زبان (از جمله چینی، انگلیسی، ژاپنی، اسپانیایی و …)

۱۵٪ خطای کلمه (WER) کمتر نسبت به ElevenLabs و GPT-4o-Audio در آزمونهای چندزبانه

لحن و ریتم وابسته به متن و زمینه برای طبیعیتر شدن صدا

🔗 منبع خبر:

https://x.com/Alibaba_Qwen/status/2003445076257656880

امتحان کنید:

Qwen Chat:

http://chat.qwen.ai

وبلاگ:

https://qwen.ai/blog?id=qwen3-tts-vc-voicedesign

VoiceDesign:

http://hf.co/spaces/Qwen/Qwen3-TTS-Voice-Design

http://modelscope.cn/studios/Qwen/Qwen3-TTS-Voice-Design

VoiceClone:

http://hf.co/spaces/Qwen/Qwen-TTS-Clone-Demo

http://modelscope.cn/studios/Qwen/Qwen-TTS-Clone-Demo

#AI #TTS #VoiceCloning

@asrgooyeshpardaz | 1 219 |

| 19 | 🚀 مدل QwenLong-L1.5 منتشر شد — مدلی برای استدلال در کانتکستهای بسیار طولانی که در این حوزه با GPT-5 و Gemini-2.5-Pro رقابت میکند.

خلاصهای کوتاه از مدل:

۳۰ میلیارد پارامتر، که از این میان ۳ میلیارد پارامتر فعال هستند

بهطور ویژه برای استدلال روی کانتکستهای بسیار طولانی بهینهسازی شده است

وزنها، کد آموزش و دستورالعملها (data recipes) بهصورت کامل متنباز منتشر شدهاند

شاخصهای کلیدی عملکرد:

+31.7 امتیاز در OpenAI MRCR با کانتکست 128K — رکورد SOTA در میان تمام مدلها

عملکرد همسطح با Gemini-2.5-Pro در ۶ بنچمارک بزرگ long-QA

+9.69 امتیاز در CorpusQA

+6.16 امتیاز در LongBench-V2

نکات جالب و نوآورانه:

دادههای سنتتیک در مقیاس بزرگ

14.1 هزار نمونه استدلالیِ طولانی

استخراجشده از 9.2 میلیارد توکن، بدون برچسبگذاری دستی

میانگین طول هر نمونه: 34 هزار توکن

حداکثر طول: 119 هزار توکن

آموزش RL پایدار

استفاده از متعادلسازی وظایف و روش Adaptive Entropy-Controlled Policy Optimization (AEPO)

این رویکرد امکان آموزش پایدار مدلها را روی توالیهای بسیار طولانی فراهم میکند

معماری مجهز به حافظه

بهروزرسانیهای تکرارشونده حافظه خارج از پنجره 256K توکن

نتیجه: +9.48 امتیاز در وظایف دارای کانتکست بین ۱ تا ۴ میلیون توکن

مدل QwenLong-L1.5 یکی از قدرتمندترین گامهای متنباز در مسیر تحقق استدلال واقعاً مقیاسپذیر روی کانتکستهای طولانی است.

این مدل نهتنها بهخاطر نتایجش، بلکه بهدلیل باز بودن کامل کل پشته آموزشی (Training Stack) نیز اهمیت ویژهای دارد.

GitHub: https://github.com/Tongyi-Zhiwen/Qwen-Doc

مقاله: https://modelscope.cn/papers/2512.12967

مدل: https://modelscope.cn/models/iic/QwenLong-L1.5-30B-A3B

Hugging Face: https://huggingface.co/Tongyi-Zhiwen/QwenLong-L1.5-30B-A3B

#AI #LLM #OpenSource #LongContext #Qwen

@asrgooyeshpardaz | 1 438 |

| 20 | ❇️ اوپنایآی در بحبوحه زیانهای سنگین تحقیقوتوسعه، حاشیه سود محاسباتی خود را به ۷۰٪ رساند.

بر اساس گزارشهای مالی داخلی، تا اکتبر ۲۰۲۵ «حاشیه محاسباتی» این شرکت به ۷۰ درصد رسیده است. این شاخص نشاندهنده سهمی از درآمد است که پس از پوشش هزینههای مستقیم اجرای مدلها برای کاربران باقی میماند. این رقم از ابتدای سال ۲۰۲۴، که تنها ۳۵ درصد بود، دو برابر شده است. چنین رشدی بیانگر موفقیت اوپنایآی در بهینهسازی زیرساخت اینفرنس است؛ امری که موجب شده مشتریان پولی بهمراتب سودآورتر شوند.

با وجود این بهینهسازیهای فنی، شرکت همچنان بهشدت زیانده است. در نیمه نخست سال ۲۰۲۵، زیان خالص اوپنایآی به ۱۳٫۵ میلیارد دلار رسید که ۶٫۷ میلیارد دلار آن صرف تحقیقوتوسعه و ساخت مدلهای جدید شده است.

با این حال، شاخصهای کسبوکار همچنان روندی صعودی دارند: درآمد سالانه شرکت از مرز ۱۲ میلیارد دلار در ماه ژوئیه عبور کرده و تحلیلگران پیشبینی میکنند تا پایان سال به سطح ۱۵ تا ۲۰ میلیارد دلار برسد.

theinformation.com

❇️ انویدیا آماده آغاز ارسال H200 به چین از ماه فوریه است.

این شرکت شرکای چینی خود را از برنامه ارسال نخستین محموله H200 در اواسط فوریه مطلع کرده است. به گفته منابع آگاه، انویدیا قصد دارد از موجودی انبارهای فعلی استفاده کرده و بین ۴۰ تا ۸۰ هزار تراشه (معادل حدود ۵ تا ۱۰ هزار ماژول) تحویل دهد. این اقدام واکنشی به نرمتر شدن سیاستهای واشینگتن است؛ بهطوری که صادرات سختافزار پرچمدار با شرط پرداخت عوارض ویژه ۲۵ درصدی مجاز شده است.

با این حال، مانع اصلی همچنان موضع پکن است. دولت چین هنوز خرید H200 را تأیید نکرده و بدون مجوز رسمی نهادهای نظارتی داخلی، این معامله نهایی نخواهد شد. در صورت حلوفصل مسئله سیاسی، انویدیا قصد دارد به یک محموله محدود بسنده نکند و از سهماهه دوم سال ۲۰۲۶ ظرفیت سفارشهای تولید جدید برای بازار چین را نیز باز کند.

reuters.com

❇️ شرکت Z.ai مدل GLM-4.7 را منتشر کرد.

مدل GLM-4.7 بهروزرسانی جدیدی از خانواده مدلهاست که بهطور ویژه برای توسعهدهندگان بهینهسازی شده است. این مدل با اندازه ۳۵۸ میلیارد پارامتر، بهبود چشمگیری در برنامهنویسی، کار با ترمینال و تولید کد UI تمیز (قابلیت Vibe Coding) نشان داده است. در بنچمارک SWE-bench Verified، عملکرد مدل به ۷۳٫۸٪ ارتقا یافته و در آزمونهای استدلال ریاضی پیچیده نیز بیش از ۱۲٪ بهبود ثبت کرده است.

نوآوری معماری این نسخه، توسعه سازوکارهای «تفکر» است. قابلیت Preserved Thinking به مدل اجازه میدهد زنجیره تفکر (CoT) را میان نوبتهای گفتگو حفظ و بازاستفاده کند و مکانیزم Interleaved Thinking پیش از هر فراخوانی ابزار خارجی، زمانی برای تحلیل در اختیار مدل قرار میدهد.

مدل GLM-4.7 هماکنون از طریق API و OpenRouter در دسترس است و وزنهای مدل نیز در HuggingFace و ModelScope منتشر شدهاند.

z.ai

❇️ ابزار Anthropic Bloom: چارچوبی برای آزمون خودکار الگوهای رفتاری هوش مصنوعی.

این ابزار فرآیند ارزیابی ایمنی مدلها را بهطور بنیادین ساده میکند: بهجای نوشتن دستی تستها، کافی است رفتار موردنظر (مانند چاپلوسی، غریزه خودحفاظتی یا تمایل به خرابکاری) توصیف شود. Bloom بر اساس این توصیف، صدها سناریوی منحصربهفرد بهصورت خودکار تولید میکند، گفتگوهایی با کاربران مجازی شبیهسازی میکند و در نهایت درباره فراوانی و شدت بروز این رفتارها گزارش میدهد.

این چارچوب از یکپارچهسازی با W&B برای رهگیری نتایج پشتیبانی میکند و امکان خروجی گرفتن لاگها در قالب Inspect را دارد. همزمان با انتشار کد منبع در GitHub، شرکت Anthropic نتایج ارزیابی ۱۶ مدل را در چهار دسته حیاتی ایمنی منتشر کرده است.

anthropic.com

❇️ سرویس Manus قابلیت Design View را اضافه کرد.

رابط Design View رابطی برای ویرایش گرافیک بهصورت point-and-click است که ترکیببندی و سبک اصلی اثر را حفظ میکند. طراحان میتوانند رنگ اشیا را تغییر دهند، عمق صحنه را تنظیم کنند و متنها را مستقیماً روی بوم اصلاح کنند. این ابزار بهطور عمیق با اکوسیستم Manus یکپارچه شده و از ویرایش ارائههای ساختهشده با Nano Banana Pro، همچنین اصلاح عناصر UI و آیکونهای اپلیکیشنهای موبایل بهصورت بلادرنگ پشتیبانی میکند.

این قابلیت هماکنون برای تمامی کاربران سرویس در دسترس است.

manus.im

#news #ai | 1 557 |