эйай ньюз

Відкрити в Telegram

Культурно освещаю самые и не самые важные новости из мира AI, и облагораживаю их своим авторитетным профессиональным мнением. Ex-Staff Research Scientist в Meta Generative AI. Сейчас CEO&Founder AI стартапа в Швейцарии. Aвтор: @asanakoy PR: @ssnowysnow

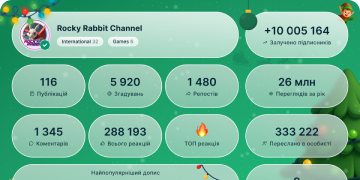

Показати більше2025 рік у цифрах

84 444

Підписники

+2224 години

-247 днів

+58230 день

Триває завантаження даних...

Схожі канали

Хмара тегів

Вхідні та вихідні згадування

---

---

---

---

---

---

Залучення підписників

грудень '25

грудень '25

+741

в 0 каналах

листопад '25

+1 390

в 0 каналах

Get PRO

жовтень '25

+2 903

в 0 каналах

Get PRO

вересень '25

+4 027

в 3 каналах

Get PRO

серпень '250

в 0 каналах

Get PRO

липень '250

в 0 каналах

Get PRO

червень '25

+3 015

в 0 каналах

Get PRO

травень '250

в 0 каналах

Get PRO

квітень '25

+5 047

в 0 каналах

Get PRO

березень '250

в 1 каналах

Get PRO

лютий '250

в 1 каналах

Get PRO

січень '25

+2 174

в 0 каналах

Get PRO

грудень '24

+4 496

в 1 каналах

Get PRO

листопад '24

+3 230

в 2 каналах

Get PRO

жовтень '24

+2 071

в 0 каналах

Get PRO

вересень '24

+3 366

в 2 каналах

Get PRO

серпень '24

+1 574

в 0 каналах

Get PRO

липень '24

+2 067

в 3 каналах

Get PRO

червень '24

+1 433

в 1 каналах

Get PRO

травень '24

+1 981

в 0 каналах

Get PRO

квітень '24

+3 974

в 3 каналах

Get PRO

березень '24

+923

в 2 каналах

Get PRO

лютий '24

+792

в 1 каналах

Get PRO

січень '24

+760

в 2 каналах

Get PRO

грудень '23

+1 394

в 5 каналах

Get PRO

листопад '23

+1 888

в 3 каналах

Get PRO

жовтень '23

+1 004

в 0 каналах

Get PRO

вересень '23

+994

в 2 каналах

Get PRO

серпень '23

+1 444

в 0 каналах

Get PRO

липень '230

в 2 каналах

Get PRO

червень '23

+24

в 5 каналах

Get PRO

травень '23

+3 270

в 0 каналах

Get PRO

квітень '23

+3 792

в 0 каналах

Get PRO

березень '23

+605

в 0 каналах

Get PRO

лютий '23

+1 653

в 0 каналах

Get PRO

січень '23

+456

в 0 каналах

Get PRO

грудень '22

+1 053

в 0 каналах

Get PRO

листопад '22

+409

в 0 каналах

Get PRO

жовтень '22

+546

в 0 каналах

Get PRO

вересень '22

+421

в 0 каналах

Get PRO

серпень '22

+634

в 0 каналах

Get PRO

липень '22

+361

в 0 каналах

Get PRO

червень '22

+1 199

в 0 каналах

Get PRO

травень '22

+746

в 0 каналах

Get PRO

квітень '22

+559

в 0 каналах

Get PRO

березень '22

+189

в 0 каналах

Get PRO

лютий '22

+199

в 0 каналах

Get PRO

січень '22

+22 530

в 0 каналах

| Дата | Залучення підписників | Згадування | Канали | |

| 26 грудня | +45 | |||

| 25 грудня | +27 | |||

| 24 грудня | +17 | |||

| 23 грудня | +18 | |||

| 22 грудня | 0 | |||

| 21 грудня | +2 | |||

| 20 грудня | +5 | |||

| 19 грудня | +3 | |||

| 18 грудня | +29 | |||

| 17 грудня | +67 | |||

| 16 грудня | +46 | |||

| 15 грудня | 0 | |||

| 14 грудня | +6 | |||

| 13 грудня | +37 | |||

| 12 грудня | +34 | |||

| 11 грудня | +26 | |||

| 10 грудня | +30 | |||

| 09 грудня | +41 | |||

| 08 грудня | +63 | |||

| 07 грудня | +21 | |||

| 06 грудня | +19 | |||

| 05 грудня | +47 | |||

| 04 грудня | +46 | |||

| 03 грудня | +35 | |||

| 02 грудня | +61 | |||

| 01 грудня | +16 |

Дописи каналу

Nvidia "покупает" Groq за $20 миллиардов

Сделка обёрнута как "соглашение о лицензировании технологий", в рамках которого Nvidia получает все технологии стартапа, а практически все ключевые сотрудники переходят работать в Nvidia. Такая практика стала популярной в последние годы — Google купил так character.ai и Windsurf, Microsoft так приобрёл Inflection и т.д. Главный плюс такого типа сделки — то что её можно провести без одобрения регуляторов. Но больше всего теряют от такого сотрудники стартапов которых оставляют позади — так как технически это не покупка, то их доля в стартапе просто обесценивается.

Оценка, конечно, космическая для такой компании и совсем непонятно чем обоснована — в сентябре компания стоила всего $6,9 миллиарда. Лично мне на ум приходят два варианта: либо страховка Nvidia против ухудшения ситуации на рынке памяти, либо специализированные системы для спекулятивного декодинга, как Nvidia уже делает с Rubin CPX чисто для префила. А вы как думаете, откуда такая оценка?

@ai_newz

16 53421331

| 2 | Как себя сегодня чувствует ML-образование

Наткнулся на исследование J'son & Partners о подготовке AI-кадров в США, Китае и России. Авторы смотрят на то, как страны пытаются закрыть разрыв между спросом на ML-специалистов и тем, что выдаёт образовательная система. Спрос растёт везде, ключевой вызов тоже общий — компетенции выпускников не соответствуют текущим задачам бизнеса.

Подходы при этом разные. Китай ставит на централизацию: государство задаёт единые стандарты, с 2025 года AI обязателен в школах с 6 лет, всё живёт на единой государственной платформе. Хорошо масштабируется, но под нестандартные задачи специалистов часто ищут за рубежом. В США модель университетская — вузы конкурируют между собой и сами обновляют программы под рынок. Обучение дорогое, при этом бигтехи тоже участвуют: Google, Meta и другие запускают совместные программы, где можно делать магистратуру или PhD параллельно с работой в компании.

В России модель строится на кооперации бигтехов и вузов: компании запускают совместные программы, открывают базовые кафедры, ведут собственные школы вроде ШАДа. Как выпускник могу сказать, что такой формат даёт и академическую базу, и понимание того, как ML работает в проде. Второе в чистом университете получить сложно — эти знания живут внутри команд и продуктов.

Так что если выбираете ML-программу, смотрите не только на вуз, но и на то, какие компании стоят за обучением. Очень круто, если получится заскочить на программу, где можно писать PhD или магистерскую прямо в компании. У меня многие знакомые так делали на программах с Facebook AI Research.

Вот, например, мой друг Никита делал так PhD на программе с Метой и пост об этом в его канале.

@ai_newz | 16 772 |

| 3 | Qwen-Image-Edit-2511: теперь и у Qwen есть своя Nano Banana

Умеет всё то же, что и аналоги от Google, OpenAI и Flux. Клёво, что Qwen тоже не отстаёт от гонки, причём их релиз вышел под лицензией Apache 2.0. Это обновление старой Qwen Image Edit, версии Qwen Image вдохновлённой Flux Kontext.

Главная фишка релиза — возможности популярных LoRA (например, для улучшения освещения или смены ракурса), интегрированы здесь прямо в базовую модель. Отдельно так же дообучили на полезные для реального дизайна фичи, такие как генерация изометрических проекций и замена материала. С этим в целом и банан явно справляется, но квен все-таки локальная и главное открытая моделька.

Модель с первого дня поддерживается LightX2V, с ускорением в 1.4 раза. А в комбинации с дистилляцией и FP8 обещают ускорение до 42-х раз.

Результаты нужно смотреть на практике, но сам факт появления сильного опенсорс-конкурента — это отлично.

Демо Hugging Face

Демо Qwen Chat

Пейпер

Обнимающее лицо

Гитхаб

@ai_newz | 23 393 |

| 4 | Microsoft планирует отказаться от C/C++ к 2030 году

О проекте гигантского переписывания кода стало известно из вакансии где для него ищут сотрудников. Цель амбициозная — миллион строчек портированного кода на человека в месяц, что было бы невозможно без использования ИИ (да и с ИИ есть сомнения). Заменой послужит Rust, который успешно применяют в компании. На него уже переписали несколько компонентов Windows, а также успешно используют в Azure.

Флаг им в руки, интересно что выйдет из этого гигантского эксперимента по переписыванию кода. Хотя если посмотреть на "успехи" Microsoft в сфере ИИ и на качество их софта в последнее время, то возникают сомнения по поводу перспектив проекта.

@ai_newz | 23 541 |

| 5 | Яндекс разработал ИИ-инструмент для автоматического анализа видеозаписей с лабораторными мышами. Такие записи — основа когнитивных исследований: по поведению животных ученые изучают работу мозга и разрабатывают методы лечения эмоциональных расстройств. Проблема в том, что ручная разметка одного 10-минутного видео занимает около часа, а для полноценного исследования нужно обработать десятки часов материала. Мои одногруппники в Хайдельбергском университете тоже занимались анализом видео с мышами (статья в Nature), так что об этой проблеме знаю не понаслышке.

Новый инструмент делает эту работу за минуты: система находит ключевые точки на теле мыши и распознает её действия с точностью 89%. Ученые уже сэкономили с его помощью 500 часов ручного труда, но это лишь начало — такая автоматизация позволяет легче масштабировать эксперименты, что ведёт к лучшему качеству. Сейчас компания предоставляет доступ к инструменту по запросу, а в будущем откроет его исходный код для всего научного сообщества. Это позволит исследователям использовать решение в других социальнозначимых проектах.

@ai_newz | 20 564 |

| 6 | Нейродайджест за неделю (#99)

LLM

- Вышла Gemini 3 Flash — Выносит 2.5 Pro, на паре бенчей обгоняет даже Gemini 3 Pro, будучи значительно дешевле. Гибридный ризонер, уже доступен в API и продуктах Google.

Генеративные модели

- FLUX.2 [max] — Уступает Nano Banana Pro, но может хорошо работать с 10 референсами.

- GPT Image 1.5 — Улучшили реализм и добавили ризонинг как в Nano Banana Pro. Вышла полноценная альтернатива.

- SAM-Audio: находка для шпиона — Meta добавила в SAM аудиомодальность. Теперь можно выделить объект на видео и услышать только его звук, отделив от остального шума.

- Kandinsky 5.0 Video на text-to-video арене — Pro-версия стала топ-1 открытой моделью в мире на T2V-арене, уступая SOTA-моделям, но наравне с Luma Ray 3.

Прочее

- mini-SGLang — Оптимизированный и минималистичный инференс-движок (~5000 строк кода) для образовательных целей и ресёрча, поддерживающий основные фичи SGLang.

- Оптимизация тренировки MoE от DaoLab — Команда Dao AI Lab снова творит магию. SonicMoE почти вдвое быстрее и эффективнее по памяти, чем лучшие открытые кернелы для тренировки MoE.

> Читать дайджест #98

#дайджест

@ai_newz | 19 013 |

| 7 | Предлагаю ребрендинг – не АИ слоп, а эко-текст и не бездушная АИ-картинка - а эко-графика

Потому что текст из LLM и генеративные АИ-картинки оставляют намного меньший отпечаток карбона в мире, чем реальные художники и писатели ☕️ | 14 301 |

| 8 | Команда Три Дао снова применяет чёрную магию оптимизации, на этот раз для ускорения тренировки MoE. SonicMoE почти в два раза быстрее лучших открытых кернелов для MoE, при этом используя почти в два раза меньше памяти для хранения активаций. На практике это повышает эффективность тренировки в полтора раза — 64 H100 с SonicMoE тренируют 7B MoE модель с такой же скоростью как 96 H100 с предыдущей лучшей имплементацией.

Пейпер

Код

@ai_newz | 24 936 |

| 9 | Kandinsky 5.0 Video на text-to-video арене

На арене появились результаты моделей Kandinsky 5.0 Video Lite и Pro.

Pro-версия — ТОП-1 открытая модель в мире.

На общем фоне Pro-версия уступает SOTA-моделям от Google, OpenAI, Alibaba и KlingAI. Но можно говорить о паритете с Luma Ray 3 и Minimax Hailuo 2.3 (отрыв по ELO максимум 3 балла, при 95% доверительном интервале оценивания +-21 балла). Lite-версия (2B параметров) оказалась лучше первой версии Sora.

Стоит отметить, что сам факт выхода российской генеративной модели на международную арену и её конкуренция с другими игроками — событие довольно редкое, я бы сказал, неожиданное.

По архитектуре это довольно немаленький (19B) DiT с кросс атеншеном на текст. При этом VAE на базе HunyuanVideo. Генерит в 24fps видео длиной 5 или 10 секунд В HD (1280x768)

Веса

GitHub

Техрепорт

@ai_newz | 26 076 |

| 10 | mini-SGLang — оптимизированный минималистичный инференс движок

Кодбаза способна на полноценный инференс Qwen 3 (Dense) и Llama 3 на уровне производительности большого SGLang, в котором на два порядка больше кода. Проект предназначен как и для обучения работе современных инференс движков, так и как минималистичная кодбаза для ресёрча.

В ~5,000 строк кода на Python влезают основные оптимизации SGLang и довольно много функционала. Движок поддерживает как онлайн (по OpenAI API) так и оффлайн инференс, инференс на нескольких GPU, context caching. Но в то же время многим пришлось пожертвовать — выкинули поддержку большинства моделей, поддержку MoE, поддержку AMD и т.д. Но сама идея иметь минималистичную версию проекта с такой же архитектурой для экспериментирования и онбординга новых контрибьюторов мне нравится, хотелось бы больше такого.

Блогпост

https://github.com/sgl-project/mini-sglang

@ai_newz | 23 355 |

| 11 | Вышла Gemini 3 Flash

Выносит по бенчам 2.5 Pro в одни ворота, при этом будучи значительно дешевле. На паре бенчмарков обгоняет даже Gemini 3 Pro. Поддерживает тот же миллион токенов контекста что и большая модель. На вход принимает текст, аудио и картинки, но на выход идёт только текст (по крайней мере пока что). При этом Gemini 3 Flash это гибридный ризонер — можно отключить рассуждения, как и с 2.5 Flash.

Цену за токен по сравнению с 2.5 Flash повысили. Заявляют что вместе с этим повысили и эффективность использования токенов. Это в теории должно было компенсировать повышение цены, но тесты говорят об обратном, по крайней мере с включённым ризонингом.

Модель уже доступна в ai.studio, Antigravity, чате и API. AI режим Google тоже переводят Gemini 3 Flash уже сегодня (наконец-то там будете нормальная модель).

Блогпост

@ai_newz | 34 462 |

| 12 | SAM-Audio: находка для шпиона

Meta продолжает расширять возможности SAM (Segment Anything Model), и теперь туда добавилась аудиомодальность.

Выделяешь объект на видео и получаешь звук, который исходит исключительно из этой точки. Как вы понимаете, это просто находка для шпиона, ведь можно выделить диалог двух людей на видео и слышать только его, отделив от всего остального шума. Какие у этого другие применения — думайте сами. А так проект выглядит довольно интересно.

В основе лежит Perception Encoder Audiovisual (PE-AV), который выступает в роли ушей системы. Сама же архитектура построена на flow-matching diffusion transformer, который принимает на вход аудиомикс и промпт, а на выходе генерирует целевой и остаточный аудиотреки.

Модель умеет отделять звук по трём типам промптов, которые можно комбинировать. Это текстовый, визуальный (клик на объект в видео), span prompting (выделение временного отрезка, когда появляется звук). Но вот выделить что-то совсем похожее пока не удастся, например, одного певца из хора вырезать не получится.

При этом модель работает быстрее реального времени (RTF ≈ 0.7) и скейлится от 500M до 3B параметров.

Веса и код выложены в опенсорс, но под некоммерческой лицензией (CC-BY-NC 4.0).

Блогпост

Демо

GitHub

@ai_newz | 28 122 |

| 13 | Вышла новая облачная IDE для удобной работы с мощным железом

Ребята из @data_secrets выкатили собственную IDE – DS Lab. Она специально заточена под быструю и удобную аренду GPU для проектов любой сложности.

Обычно аренда железа – это часы настроек и установок. Ну или, в случае с Colab, – пресловутое «Are you still here???» и невозможность работать с полноценным проектом.

А здесь ребята действительно приблизились к тому, чтобы сделать процесс максимально комфортным. Что понравилось:

1. Понятный интерфейс и моментальный доступ к железу. Выглядит как привычная IDE, и чтобы подключить к проекту ресурсы, надо просто выбрать конфигурацию. Все настройки остаются за кадром.

2. Доступны редкие видеокарты H100, H200, A100 и другие. Оплата происходит as you go посекундно, переплатить буквально невозможно. Есть бесплатная подписка, которая дает доступ к GPU-конфигурациям.

3. В отличие от Colab после завершения сеанса ваши результаты никуда не пропадут, и вы сможете продолжить работу с того же места. Реализована довольна удобная работа с файлами.

Попробовать можно тут -> dslab.tech. Для ML-щиков 100% must try.

И кстати, в канале проекта @dslab сейчас разыгрывают 3000 GPU-часов. От такого уж точно никто не откажется ☕️

#промо | 13 695 |

| 14 | вышло.. GPT Image 1.5

Реализм сильно улучшили. Это заявка на конкуренцию с Nano Banana Pro.

Заявлено, что можель работает в 4x раза быстрее чем GPT-Image 1. Но это оказалсь не правдой.

Картинка на 1.5MP генерится 60-65 сек – против ~90 сек у GPT-Image 1. Ускрорение есть, но это все равноу супер медленно. Нана банана генерит в 2 раза быстрее.

На лидербордах GPT Image 1.5 пока нет. Думаю, что будет где-то между Nano Banan Pro и Nano Banan.

@ai_newz | 77 706 |

| 15 | Вот так-то лучше.

@ai_newz | 23 314 |

| 16 | Мог бы и по-лучше черипик выбрать. Желтый воротник под розовым как-то не очень.

@ai_newz | 19 274 |

| 17 | 🔥FLUX.2 [max]

Парни из BFL зарелизили свой самую мощную модель!

* Grounded generation — ищет в интернете актуальный контекст в реальном времени: результаты вчерашних матчей, текущую погоду, исторические события с точными деталями. Просто добавьте в запрос фразу «Search the internet» — и магия начнётся.

* До 10 референсных изображений. Продукты, персонажи и стили остаются консистентными.

На лидерборде lmarena.ai модель занимает 3 и 7 место:

🔹 #3 на Text-to-Image

🔹 #7 на Image Edit

А на лидерборде artificialanalysis.ai:

🔹 #2 Text-to-Image и на Image Edit

Доступна только по API (ссылка на fal), лоры тренить тоже нельзя.

Скидывайте свои тесты в комменты.

@ai_newz | 31 632 |

| 18 | Нейродайджест за неделю (#98)

LLM

- Ramanujan-1 — Стартап одного из авторов трансформера выпустил 8B-модель, тренированную на AMD/TPU. Неплоха на общих задачах, но сияет в агентском кодинге, где показывает феноменальные результаты для своих 8B.

- Devstral 2 — локальный вайбкодинг — Mistral реабилитировались за Large 3. Devstral Small 2 (24B) на уровне GLM 4.6 по кодингу и запускается локально. Вместе с моделями выпустили и Vibe CLI — своего конкурента Claude Code.

Прочее

- Уход Яна Лекуна из Meta — Один из крёстных отцов AI уходит, чтобы основать стартап по World Models. Пара моих мыслей, разбор причин и конец целой эпохи в FAIR.

Личное

- Ищу Executive Assistant в мой стартап GenPeach.ai

> Читать дайджест #97

#дайджест

@ai_newz | 22 055 |

| 19 | Пара мыслей про уход Яна Лекуна из Meta

Вы уже наверное слышали, что мой друг Ян ЛеKун, один из крёстных отцов AI и Chief AI Scientist в Meta, объявил, что уходит мз компании после 12 лет, и доработает только до конца декабря.

As many of you have heard through rumors or recent media articles, I am planning to leave Meta after 12 years: 5 years as founding director of FAIR and 7 years as Chief AI Scientist.

The impact of FAIR on the company, on the field of AI, on the tech community, and on the wider world has been spectacular. The creation of FAIR is my proudest non-technical accomplishment.

I am creating a startup company to continue the Advanced Machine Intelligence research program (AMI) I have been pursuing over the last several years with colleagues at FAIR, at NYU, and beyond. The goal of the startup is to bring about the next big revolution in AI: systems that understand the physical world, have persistent memory, can reason, and can plan complex action sequences.

I am extremely grateful to Mark Zuckerberg, Andrew Bosworth, Chris Cox, and Mike Schroepfer for their support of FAIR, and for their support of the AMI program over the last few years. Because of their continued interest and support, Meta will be a partner of the new company.

As I envision it, AMI will have far-ranging applications in many sectors of the economy, some of which overlap with Meta’s commercial interests, but many of which do not. Pursuing the goal of AMI in an independent entity is a way to maximize its broad impact.

I will give some more details about the new company when the time comes. In the meantime, I’m sticking around Meta until the end of the year.

Официально, он уходит, чтобы основать свой стартап, где он будет строить World Models и продолжать свой давний крестовый поход против нынешнего тренда на LLM.

По мнению Яна, настоящий интеллект — это не просто предсказание следующего слова. Моделям нужна настоящая связи с физическим миром, AI системы должны понимать физический мир, иметь постоянную память, уметь рассуждать и планировать сложные цепочки действий. Это и есть его концепция World Models. Простой пример: eсли бы у нас была "модель мира" (World Model), то мы могли бы научить системы уверенно предсказывать, что произойдёт дальше в физическом мире – например роборука заранее бы могла предсказать, что произойдет если столкнуть кружку со стола.

Что-то подобное, кстати, пытается построить и Фей-Фей Ли в своём стартапе - но пока это на очень ранней стадии и ничего умного, кроме как генерации 3D пространств там нет.

--

В последние месяцы в Meta наметился явный конфликт видений. С одной стороны — Марк, который загорелся идеей AGI и требует от команд быстрых продуктовых результатов в гонке с OpenAI. С другой — Ян, который критикует нынешние LLM и считает, что до настоящего AGI ещё очень далеко. На этом фоне Цукерберг купил продуктово-ориентированных лидера Александра Ванга, вместе с половиной Scalе AI, что только усилило расхождение. Да и это унизительно для ЛеКуна - репортить Алексу, которые мнение ЛеКуна ни во что не ставит. Я больше писал об этом здесь, где так же предсказал уход ЛеКуна.

Meta, будет строить новые LLM, пытаясь догнать GPT, а ЛеКун, освободившись от корпоративного давления, займётся тем, во что верит сам.

Это не просто уход топ-менеджера (а Ян и не был менеджером). Ян был талисманом FAIR, лицом которого всегда можно было светануть, чтобы показать насколько крутые люди работают над ресерчем в Мете – это была репутационнная история как минимум. Жаль что эта эпоха закончилась.

Что ж, будем следать за тем что выдаст Ян ЛеКун в ближайшее время!

@ai_newz | 26 102 |

| 20 | Привет! Принёс инсайт для петербуржцев – где искать местное ML‑комьюнити.

В 2014 году я окончил Школу анализа данных. Если не знаете, ШАД – это хардовая двухгодичная программа Яндекса по подготовке датасаентистов и ML-щиков. Учёба там мне много чего дала, так что рекомендую.

Недавно я узнал, что в Питере уже два года существует пространство ШАДа, доступное не только для студентов, но и всех, кто интересуется DS/ML. Вчера отмечали его двухлетие, на которое меня позвали как выпускника. Я не смог приехать лично, но передал пригласительный товарищу – интересно было посмотреть, чем сейчас живут ML‑щики в Питере.

На ивенте была программа: эксперт из облачных сервисов Яндекса читал лекцию о деплойменте AI‑систем в прод, руководитель ШАД Алексей Толстиков поднял вопрос разницы и преимуществ соревновательного и классического форматов обучения.

Но для меня самое главное в таких историях – это нетворкинг. Организаторы сделали несколько открытых дискуссий, а с самого входа предлагали поучаствовать в активности на знакомства. Как по мне, это очень крутая возможность для общения, обмена идеями. Так можно и команду собрать, и новый проект запустить.

@ai_newz | 24 427 |