عصر گویش | هوش مصنوعی

Kanalga Telegram’da o‘tish

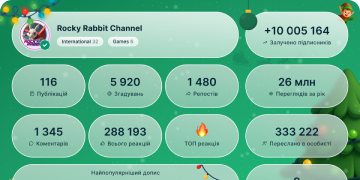

2025 yil raqamlarda

111 659

Obunachilar

-14124 soatlar

-7907 kunlar

-3 15130 kunlar

Postlar arxiv

❇️ هوش مصنوعی فعالیت عضلات پنهان دست را تنها از روی ویدئو تشخیص میدهد

تیمی از Institute of Science Tokyo فریمورک جدیدی به نام PianoKPM Net معرفی کرده است که میتواند بدون استفاده از حسگرهای پوشیدنی، با دقت بالا الگوهای فعال شدن عضلات دست را از روی ویدئو بازسازی کند.

معمولاً این نوع تحلیل نیازمند الکترومایوگرافی (EMG) است که هم پرهزینه و هم تهاجمی است؛ اما معماری جدید با تحلیل تصویر ویدئویی، الگوهای انقباض عضلات را تخمین میزند.

هستهٔ این سیستم یک دیتاست منحصربهفرد شامل ۱۲ ساعت اجرای پیانیستهای حرفهای است که دادههای تصویری آن با سیگنالهای واقعی عضلات همگامسازی شده است. این فناوری دوربین معمولی را به ابزاری تشخیصی تبدیل میکند که برای توانبخشی پزشکی، تحلیل ورزشی و ساخت رابطهای پیشرفتهٔ «انسان–رایانه» اهمیت بالایی دارد.

به گفتهٔ نویسندگان، مدل و دیتاست به صورت متنباز منتشر خواهد شد.

لینک:

https://techxplore.com/news/2025-11-ai-decodes-pianists-muscle-video.html

❇️ پروژهٔ هوش مصنوعی جف بزوس استارتاپ General Agents را خرید

پروژهٔ Prometheus متعلق به جف بزوس، استارتاپ Agentic AI با نام General Agents را تصاحب کرده است. این معامله تابستان امسال و به شکل کاملاً محرمانه انجام شده و همراه با آن، گروهی از مهندسان پیشین DeepMind و Tesla نیز به Prometheus پیوستهاند.

هدف پروژهٔ Prometheus توسعهٔ سیستمهای هوش مصنوعی برای پشتیبانی از فرایندهای پیچیده در صنایع خودروسازی و هوافضا است.

مهمترین دارایی General Agents فناوری Ace برای کنترل خودکار رابطها و اپلیکیشنهاست. هرچند Ace ابتدا برای خودکارسازی کارهای روزمرهٔ کامپیوتری ساخته شده بود، اما اکنون انتظار میرود این فناوری در Prometheus برای کاربردهای صنعتی در مقیاس بزرگ توسعه یابد.

لینک:

https://www.wired.com/story/jeff-bezos-new-ai-company-acquired-agentic-computing-startup/

❇️شرکت OpenAI و گوگل محدودیتهای شدیدی بر Sora و Nano Banana Pro اعمال کردند

«بیل پیبلز»، مدیر بخش Sora در OpenAI اعلام کرد که حسابهای رایگان اکنون تنها روزانه ۶ ویدئو میتوانند تولید کنند، زیرا پردازندههای گرافیکی شرکت تحت فشار شدید هستند. این محدودیت موقتی به نظر نمیرسد و OpenAI پیشنهاد کرده است که کاربران در صورت نیاز، اعتبار اضافه خریداری کنند. شرایط برای مشترکان ChatGPT Plus و Pro فعلاً بدون تغییر مانده است.

گوگل نیز اقدام مشابهی انجام داده و دسترسی رایگان به ابزار Nano Banana Pro را به ۲ تصویر در روز کاهش داده است. این شرکت هشدار داده که محدودیتها میتوانند بدون اعلان قبلی و به صورت پویا تغییر کنند. همچنین دسترسی کاربران رایگان به Gemini 3 Pro نیز محدود شده است.

لینک:

https://www.theverge.com/news/831760/openai-google-rate-limit-sora-nano-banana-pro

❇️ شرکت Perplexity قابلیت حافظهٔ بلندمدت را فعال کرد

جستجوگر هوشمند Perplexity به قابلیت جدید persistent memory مجهز شده است که به سیستم امکان میدهد ترجیحات، علایق و جزئیات مکالمات گذشتهٔ کاربر را به خاطر بسپارد.

این ویژگی باعث میشود پاسخها شخصیسازیشدهتر باشند و نیاز به پرسشهای تکمیلی کاهش یابد.

شرکت Perplexity این دادهها را از حافظه استخراج کرده و مستقیماً در تولید پاسخ به کار میگیرد. این لایهٔ زمینهای روی هر مدلی که کاربر انتخاب کند فعال است و دانش انباشتهشدهٔ مربوط به کاربر را از دست نمیدهد.

این قابلیت به صورت کامل قابل مدیریت است: میتوان ذخیرهٔ داده را خاموش کرد و در حالت ناشناس (Incognito) هیچ تاریخی ذخیره نمیشود.

لینک:

https://www.perplexity.ai/hub/blog/introducing-ai-assistants-with-memory

#خبر

#هوش_مصنوعی

❤ 2🔥 1👏 1👌 1

⚡️ مدل NVIDIA Orchestrator-8B: نسل جدید کنترلگرهای هوشمند برای انتخاب ابزار و مدلهای تخصصی

انویدیا از Orchestrator-8B پردهبرداری کرد؛ مدلی با ۸ میلیارد پارامتر که برخلاف رویکرد معمول «اتکا به یک مدل بزرگ»، وظیفهاش هدایت هوشمند درخواستها بین ابزارها و مدلهای مختلف است. این معماری جدید، یک گام مهم در جهت Agentic AI و سیستمهای خودکار چندابزاره محسوب میشود.

🔍 ایده اصلی

Orchestrator-8B به جای حل مستقیم مسئله با یک مدل واحد، فرآیند چند مرحلهای استفاده از ابزارها را به صورت یک فرایند تصمیمگیری مارکوف (MDP) مدلسازی میکند. سپس با یک تابع پاداش چندهدفه—شامل دقت، هزینه، تأخیر (latency) و ترجیحات کاربر—بهینهسازی میشود.

🧠 ابزار اصلی آموزش: ToolScale

انویدیا برای آموزش گسترده از ToolScale بهره گرفته است؛ مجموعهای بزرگ از وظایف ترکیبی که شامل فراخوانی ابزارها، جستجوی وب، بازیابی اطلاعات، اجرای کد و مدلهای زبانی تخصصی میشود.

🚀 عملکرد

بر اساس گزارشها، Orchestrator-8B در بنچمارکهای Humanity’s Last Exam، FRAMES و τ² Bench توانسته است:

بهتر از GPT-5 در حالت Tool-Baseline عمل کند

۳۰٪ هزینه کمتر داشته باشد

حدود ۲.۵ برابر تأخیر کمتر ارائه دهد

علت اصلی این برتری، توزیع هوشمند ریکوئستها بین مدلهای تخصصی، جستجوی وب، بازیابی، و اجرای کد است—آن هم با در نظر گرفتن هزینه و سرعت.

🎯 اهمیت استراتژیک

این مدل نشان میدهد که آینده سیستمهای هوشمند نه در یک «ابرمدل واحد»، بلکه در ارکستراسیون بهینه چند مدل و چند ابزار است؛ الگویی کلیدی برای نسل بعدی Agentic AI و سیستمهای خودکار سازمانی.

🔗 منابع

• تحلیل کامل:

https://www.marktechpost.com/2025/11/28/nvidia-ai-releases-orchestrator-8b-a-reinforcement-learning-trained-controller-for-efficient-tool-and-model-selection/

• مقاله:

https://arxiv.org/pdf/2511.21689

• وزن مدل:

https://huggingface.co/nvidia/Orchestrator-8B

• ریپازیتوری:

https://github.com/NVlabs/ToolOrchestra/

• پروژه:

https://research.nvidia.com/labs/lpr/ToolOrchestra/

• ویدئو:

https://youtu.be/0yfyrwP6uOA

@asrgooyeshpardaz

🔥 2🤝 1

🔬 معرفی STARFlow-V؛ نسل تازهای از مدلهای تولید ویدئو بر پایهٔ جریانهای نرمالسازی (Normalizing Flows)

گروهی از پژوهشگران اپل در تازهترین گزارش علمی خود، از STARFlow-V پرده برداشتند؛ مدلی نوآورانه برای تولید خودرگرسیو ویدئو که برخلاف جریان غالب فناوریهای ویدئوسازی، نه بر مبنای «دیفیوژن»، بلکه بر پایهٔ جریانهای نرمالسازی (Normalizing Flows) طراحی شده است. این دستاورد، نخستین شواهد جدی را ارائه میکند که نشان میدهد این خانواده از مدلها —که به شفافیت محاسباتی و قابلیت محاسبهٔ دقیق احتمال شهرت دارند— میتوانند در حوزهٔ پیچیدهٔ ویدئو نیز به کیفیت رقابتی دست یابند.

✨ مهمترین دستاوردهای STARFlow-V

🔹 معماری جهانی–محلی (Global–Local):

در این مدل، پردازش طولانیمدت و روابط زمانی به یک «فضای نهفتهٔ جهانی» سپرده میشود و جزئیات ظریف هر فریم در «بلوک محلی» پردازش میگردد. این تفکیک معماری باعث کاهش چشمگیر خطای انباشتی در تولید ویدئوهای طولانی میشود؛ مشکلی که معمولاً گریبانگیر مدلهای دیفیوژن خودرگرسیو است.

🔹 یادگیری کاملاً انتهابهانتها (End-to-End):

برخلاف مدلهای دیفیوژن که نیازمند زمانبندیهای پیچیدهٔ نویزی و فرایندهای چندمرحلهای هستند، این مدل بهطور کامل با بیشینهسازی درستنمایی آموزش داده میشود و از ناسازگاری آموزش–آزمون رنج نمیبرد.

🔹 روش نوین Flow-Score Matching:

پژوهشگران برای رفع نویز ذاتی نمونهگیری در مدلهای جریان، یک «زدایندهٔ علّی سبکوزن» طراحی کردهاند که افزون بر بهبود پایداری ویدئو، قابلیت تولید تدریجی و علّی (streamable) را حفظ میکند.

🔹 شتابدهی چشمگیر در نمونهگیری:

با اتکا بر تکرارهای یعقوبی (Jacobi Iteration) آگاه از ساختار ویدئو و زمانبندی پایپلاینی، سرعت تولید تا ۱۵ برابر نسبت به اجرای خودرگرسیو استاندارد افزایش یافته است.

🔹 یک مدل واحد برای سه کارکرد:

به دلیل ساختار کاملاً برگشتپذیر، STARFlow-V بدون هیچ تغییر معماری قادر است:

متن به ویدئو (T2V)

تصویر به ویدئو (I2V)

ویدئو به ویدئو (V2V)

را اجرا کند. این ویژگی، کارایی آن را در تدوین خودکار ویدئو و تولید محتوا چشمگیرتر میکند.

📊 نتایج و ارزیابیها

این مدل در مجموعهبنچمارک VBench، در سطحی قابل رقابت با مدلهای خودرگرسیو دیفیوژن ظاهر شده و در برخی جنبهها مانند پایداری زمانی و انسجام بلندمدت، برتری محسوسی نشان میدهد.

مدل STARFlow-V توانسته ویدئوهایی بسیار فراتر از طول آموزش (۳۰ ثانیه در برابر ۵ ثانیهٔ آموزشی) با یکپارچگی بصری مناسب تولید کند؛ قابلیتی که برای کاربردهای شبیهسازی و مدلهای جهان (World Models) اهمیت ویژه دارد.

⚠️ محدودیتها و چشمانداز آینده

با وجود پیشرفت چشمگیر، پژوهشگران سه چالش اصلی را برشمردهاند:

۱. سرعت اجرای همچنان پایین نسبت به نیازهای زمانواقعی

۲. حساسیت به کیفیت دادههای آموزشی و نبود قانون اساسی مقیاسپذیری

۳. بروز مواردی از تولید غیرواقعنما در صحنههای پیچیده یا فیزیکی

در ادامه، تیم پژوهش اپل قصد دارد بر افزایش کارایی، کاهش هزینهٔ محاسباتی، تقطیر مدلها و بهبود دادههای آموزشی تمرکز کند.

🧭 جمعبندی

مدل STARFlow-V را میتوان نقطهٔ عطفی در ورود جریانهای نرمالسازی به عرصهٔ تولید ویدئو دانست؛ رویکردی که میتواند در آینده رقیبی جدی برای دیفیوژن باشد و بهویژه در کاربردهای آیندهنگر، تعاملی و علّی، چارچوبی توانمند و انعطافپذیر ارائه کند. این پیشرفت مسیر تازهای را برای طراحی مدلهای جهان و سیستمهای شبیهسازی بصری میگشاید.

🔗منبع:

https://starflow-v.github.io/

@asrgooyeshpardaz

❤ 1🔥 1🤓 1

📄 معماری TiDAR: معماری جدیدی که دیفیوژن و خودرگرسیونی را در یک مدل واحد ترکیب میکند

🔍 مسئله:

مدلهای خودرگرسیونی (AR) با اینکه کیفیت بالایی دارند، اما کند هستند. در مقابل، مدلهای دیفیوژنی سریعاند، اما کیفیت خروجی آنها پایینتر است.

💡 راهکار TiDAR:

«اندیشیدن» و تولید پیشنویس توکنها بهصورت موازی با روش دیفیوژنی 🌀

«سخن گفتن» و نهاییسازی خروجی با روش خودرگرسیونی (AR) ✅

همه اینها فقط در یک گذر انجام میشود! 🚀

📊 نتایج (برای مدلهای 1.5B و 8B):

سرعت: ۴.۷۱ تا ۵.۹۱ برابر سریعتر از مدلهای AR 🏎

کیفیت: همسطح مدلهای خودرگرسیونی 🏆

کارایی: بهتر از Speculative Decoding و مدلهای دیفیوژنی خالص

✨ مزایا:

یک مدل برای دو نوع وظیفه

پشتیبانی کامل از KV Cache

آموزش بدون نیاز به تنظیمات پیچیدهٔ ابرپارامترها

معماری TiDAR افقهای تازهای برای نسل آیندهٔ مدلهای تولیدی سریع و باکیفیت میگشاید! 🌟

🔗 لینک مقاله:

https://arxiv.org/abs/2511.08923

#AI #NVIDIA #تحقیقاتی

@asrgooyeshpardaz

👍 1👏 1💯 1

08:21

Video unavailableShow in Telegram

🧬 روش EGGROLL: روشی تکاملی برای آموزش مدلهای عظیم

پژوهشگران روش جدیدی با نام EGGROLL معرفی کردهاند که فرآیند آموزش مدلهای بسیار بزرگ با میلیاردها پارامتر را بهطور چشمگیری سریعتر میکند.

✨ تغییرات کلیدی

• جایگزینی پسانتشار (backpropagation) با استراتژیهای تکاملی

• کاهش مصرف حافظه تا ۱۰۰ برابر ⚡️

• سرعتی نزدیک به اجرای عادی مدل 🚀

🔧 چکیدهٔ فنی

این روش از «تغییرات کمرتبهٔ ماتریسی» استفاده میکند — ماتریسهای فشردهای که بدون افت کارایی باعث صرفهجویی در مصرف منابع محاسباتی میشوند.

🎯 مزایا

• امکان آموزش با اعداد صحیح ۸ بیتی

• موازیسازی گسترده روی سختافزارهای ساده

• حذف گلوگاههای ارتباطی بین دستگاهها

📈 نتایج

پیشتمرین موفق مدلهای زبانی بدون گرادیان، که افقهای جدیدی برای مقیاسپذیری هوش مصنوعی میگشاید.

حال میتوان مدلهای بسیار بزرگ را در شرایطی آموزش داد که backprop قابلاستفاده نیست — از پارامترهای گسسته و توابع غیردیفرانسیلی گرفته تا محدودیتهای سختافزاری! 💥

🔓 کد منبع:

https://eshyperscale.github.io/

🔗 https://arxiv.org/abs/2511.16652

#پژوش #هوش_مصنوعی

@asrgooyeshpardaz

46.07 MB

❤ 1🔥 1👨💻 1

🚀 مجموعه Hugging Face نسخهٔ DeepSite v3 را منتشر کرد

نسخهی جدید و پیشرفتهی ویرایشگر هوشمند وبسایت که بهصورت آنی سایت تولید میکند—و کاملاً مبتنی بر مدلهای متنباز است! ✨

قابلیتها:

➡️ تولید کد کامل یک وبسایت تنها از یک توضیح متنی 🗣➡️💻

➡️ حالت Enhance برای بهبود هوشمندانهی طرح و ساختار 🧠

➡️ دیپلوی یککلیک با مقیاسپذیری خودکار 🚀

➡️ محیط ویرایش تمیز با تم تیره 👨💻

ابزاری ایدهآل برای توسعهدهندگان، طراحان و حتی کاربران تازهکار.

ایدههای خود را در چند ثانیه به وبسایتهای واقعی و آمادهی اجرا تبدیل کنید! ⚡️🔗 https://huggingface.co/deepsite @asrgooyeshpardaz

❤ 1🔥 1

🚨 رخداد امنیتی Mixpanel: چه بر سر دادههای OpenAI آمد؟

شرکت OpenAI اعلام کرده است که بهدلیل یک نفوذ امنیتی در سرویس تحلیل داده Mixpanel، بخشی از اطلاعات کاربران بخش platform.openai.com در معرض خطر قرار گرفته است. سایر محصولات OpenAI از جمله ChatGPT تحت تأثیر این حادثه نبودهاند.

🔍 جزئیات حادثه

تاریخ وقوع حمله: ۹ نوامبر ۲۰۲۵

دامنه آسیب: تنها کاربران platform.openai.com

عدم تأثیر روی: ChatGPT و دیگر محصولات تجاری OpenAI

📄 چه دادههایی ممکن است افشا شده باشند؟

👤 نام ثبتشده در حساب API

📧 آدرس ایمیل

🌍 موقعیت جغرافیایی تقریبی

💻 اطلاعات مرورگر و سیستمعامل

🆔 شناسه کاربر یا سازمان

🔐 چه دادههایی افشا نشدهاند؟

گذرواژهها

کلیدهای API

اطلاعات پرداخت

محتوای پیامها، پرسشها و پاسخها

🛡 اقدامات OpenAI

حذف کامل Mixpanel از زنجیره خدمات

اطلاعرسانی به کاربران تحت تأثیر

تقویت الزامات امنیتی برای تمام شرکای خارجی

⚠️ هشدار مهم

احتمال افزایش حملات فیشینگ وجود دارد.

شرکت OpenAI هرگز از طریق ایمیل درخواست گذرواژه، کلید API یا اطلاعات حساس نمیکند.

@asrgooyeshpardaz

🥱 1

🔒 نشت فرادادههای کاربران API اوپنایآی از طریق سرویس Mixpanel

اوپنایآی جزئیات یک رخداد امنیتی را که در سامانهی پیمانکار — پلتفرم تحلیل Mixpanel — رخ داده بود، منتشر کرد. مهاجمان به سامانههای تأمینکننده دسترسی پیدا کرده و فرادادههای کاربرانِ در تعامل با API را استخراج کردهاند. اطلاعات منتشرشده شامل نامها، نشانیهای ایمیل، شناسهٔ کاربری (User ID)، شناسهٔ سازمانها، اطلاعات مرورگر و سیستمعامل مورد استفاده و تقریبی از موقعیت جغرافیایی است. اوپنایآی میگوید دادههای حساس و حیاتی محفوظ ماندهاند: گذرواژهها، کلیدهای API، اطلاعات پرداخت و پرامپتها (دستورهای ورودی) فاش نشدهاند. این حادثه کاربران ChatGPT را نیز تحت تأثیر قرار نداده است. در پاسخ، اوپنایآی Mixpanel را از محصولات خود جدا کرده و همکاری با این شرکت را بهطور کامل خاتمه داده است.

منبع خبر

🌏 شرکتهای بزرگ تکنولوژی چین آموزش مدلهای هوش مصنوعی را به خارج منتقل میکنند

علیبابا و بایتدنس بهطور گسترده آموزش مدلهای زبانی بزرگ (LLM) را به جنوبشرقی آسیا منتقل کردهاند. مقصدهای اصلی مهاجرت به سنگاپور و مالزی اعلام شدهاند تا از راه قانونی به شتابدهندههای انویدیا دسترسی پیدا کنند؛ چرا که ارسال مستقیم این سختافزارها به جمهوری خلق چین مسدود شده است. استفاده از مراکز دادهٔ خارجی بهصورت رسمی با تحریمها تداخل ندارد و پس از لغو «قانون صادرات/توزیع» از سوی دولت آمریکا این مسیر پُرریسک کمتر شده است. استثنایی به نام DeepSeek همچنان آموزش مدلها را داخل چین ادامه میدهد و از موجودی کارتهای انویدیا و همکاری با مهندسان هواوی استفاده میکند. در صنعت در حال شکلگیری یک معماری هیبریدی است: آموزش روی خوشههای خارج از کشور انجام میشود و استنتاج (inference) بیشتر روی تراشههای بومی چین انجام میگیرد.

منبع خبر

🕶️ علیبابا از عینک هوشمند «کوآرک» رونمایی کرد

غول فناوری چین، فروش عینک هوشمند Quark را آغاز کرد؛ دستگاهی که ظاهراً از لحاظ ظاهری تفاوتی با فریمهای معمولی ندارد و تحت کنترلی مدل Qwen کار میکند. قیمت آغازین این گجت حدود ۲۶۸ دلار اعلام شده است. مهندسان تمرکز خود را بر خودمختاری و یکپارچگی با اکوسیستم گذاشتهاند: دستگاه دارای باتریهای قابل تعویض، اپتیک دوگانه و سیستم تصویربرداری حرفهای است. این عینک به سرویسهای شرکت گره خورده و کاربران میتوانند از دستیار بصری برای ترجمهٔ فوری، پرداخت از طریق Alipay و شناسایی کالاها جهت جستجوی قیمت در Taobao استفاده کنند.

منبع خبر

🎬 اپل روشی جایگزین برای شبکههای انتشار-محور (Diffusion) معرفی کرد

اپل مقالهای منتشر کرده که رویکردی نو در تولید ویدئو ارائه میدهد و میتواند مدلهای مبتنی بر فرایندهای انتشار (diffusion) را به چالش بکشد. سیستم STARFlow-V مبتنی بر معماری «نرمالسازی جریانی» (streaming/flow normalization) طراحی شده و بهمثابهٔ یک مدل یکپارچه برای پردازش متن، تصویر و ویدئو آموزش میبیند. برخلاف روشهای انتشار که به تکرارهای زیاد برای حذف نویز نیاز دارند، STARFlow-V از یک نگاشت یکبارهٔ قابلمعکوس و منطق علّی-معلولی صریح استفاده میکند. بلوک جهانی مدل بهصورت خودبازگشتی (autoregressive) عمل میکند؛ یعنی تولید هر لاتنت جدید تنها به دادههای قبلی وابسته است. برای افزایش سرعت محاسبات، از بهروزرسانیهای متوازی یاکوبی استفاده شده که کیفیتی در سطح SOTA همراه با پایداری بالاتر ارائه میدهد.

منبع خبر

🧪 ابزار AdvancedIF: معیار سختتری برای سنجش پیروی LLMها از دستورالعملهای پیچیده

آزمایشگاه متا (وابسته به مارک زاکربرگ) ابزار AdvancedIF را توسعه داده تا مرزهای واقعی مدلهای زبانی در اجرای دستورالعملهای پیچیده را آشکار کند. این بنچمارک روی سناریوهای دارای بار شناختی بالا تمرکز دارد: مجموعهداده بیش از ۱۶۰۰ پرامپت را دربر میگیرد که هر کدام شامل شش شرط همزمان میشوند—از نیازمندیهای قالب و سبک تا محدودیتهای منفی و وابستگیهای منطقی متقاطع. علاوه بر تستهای تکدرخواست، AdvancedIF توانایی کنترلپذیری مدلها با پرامپتهای سیستمی و حفظ زمینهٔ گفتگو در دیالوگهای پیچیده را نیز ارزیابی میکند. بهعنوان داور از مدل o3-mini استفاده میشود که پاسخهای مدل را بر اساس معیارهای تدوینشده توسط کارشناسان انسانی مطابقت میدهد. ابزار از پردازش دستهای پشتیبانی میکند و مجموعهداده آن روی Hugging Face در دسترس است.

منبع خبر

#خبر #هوش_مصنوعی

@asrgooyeshpardaz

❤ 1🤔 1🤝 1

08:09

Video unavailableShow in Telegram

🤖 مدل DeepSeekMath-V2: هوش مصنوعیای که خود، برهانهای ریاضیاش را بازبینی میکند ✨

مدل جدید دیپ سیک تنها به حل مسئله بسنده نمیکند، بلکه استدلالهای خود را نیز تحلیل میکند.

میتواند خطاهای موجود در برهانهایش را بیابد و اصلاح کند.

توانایی حل مسائل سطح بالای المپیادهای ریاضی را دارد. 🏆

دستاوردهای کلیدی:

کسب مدال طلا در المپیاد جهانی ریاضی ۲۰۲۵ 🥇

۱۱۸ از ۱۲۰ در آزمون پاتنام ۲۰۲۴ (بالاتر از بهترین نتیجهٔ انسانی!)

حل مسائلی که انسانها برای حل آنها ساعتها زمان صرف میکنند.

شیوهٔ کار:

ابتدا برهان را تولید میکند.

سپس آن را بر اساس معیارهای سختگیرانه بررسی میکند.

خطاهای یافتشده را اصلاح میکند.

این چرخه تا رسیدن به نتیجهٔ بینقص تکرار میشود.

🤖 این گامی بزرگ به سوی هوش مصنوعیای است که واقعاً ریاضی را میفهمد، نه اینکه تنها پاسخها را حدس بزند!

🔗 لینک:

https://github.com/deepseek-ai/DeepSeek-Math-V2/blob/main/DeepSeekMath_V2.pdf

#AI #DeepSeek #پژوهش

38.66 MB

❤ 5🔥 1😐 1🤝 1

🤖 مدل DeepSeekMath-V2: هوش مصنوعیای که خود، برهانهای ریاضیاش را بازبینی میکند ✨

مدل جدید دیپ سیک تنها به حل مسئله بسنده نمیکند، بلکه استدلالهای خود را نیز تحلیل میکند.

میتواند خطاهای موجود در برهانهایش را بیابد و اصلاح کند.

توانایی حل مسائل سطح بالای المپیادهای ریاضی را دارد. 🏆

دستاوردهای کلیدی:

کسب مدال طلا در المپیاد جهانی ریاضی ۲۰۲۵ 🥇

۱۱۸ از ۱۲۰ در آزمون پاتنام ۲۰۲۴ (بالاتر از بهترین نتیجهٔ انسانی!)

حل مسائلی که انسانها برای حل آنها ساعتها زمان صرف میکنند.

شیوهٔ کار:

ابتدا برهان را تولید میکند.

سپس آن را بر اساس معیارهای سختگیرانه بررسی میکند.

خطاهای یافتشده را اصلاح میکند.

این چرخه تا رسیدن به نتیجهٔ بینقص تکرار میشود.

🤖 این گامی بزرگ به سوی هوش مصنوعیای است که واقعاً ریاضی را میفهمد، نه اینکه تنها پاسخها را حدس بزند!

🔗 لینک:

https://github.com/deepseek-ai/DeepSeek-Math-V2/blob/main/DeepSeekMath_V2.pdf

#AI #DeepSeek #پژوهش

❤ 1

💡 انتشار Z-Image: مدل سریع ۶ میلیاردی

تیم Tongyi-MAI معماری تازهای برای تولید تصویر از متن با ۶ میلیارد پارامتر معرفی کرده است. مهمترین نکات گزارش به این شرح است:

🔹بهینهسازی: این مدل نسخهای تقطیرشده است که تنها با ۸ گام (NFE) تصاویر باکیفیت تولید میکند.

🔹سرعت: دارای زمان تأخیر کمتر از یک ثانیه روی H800 است.

🔹نیازمندیها: بهراحتی روی ۱۶ گیگابایت VRAM اجرا میشود و برای استقرار محلی روی کارتهای 3090/4080/4090 مناسب است.

🔹این مدل از نظر فوتورئالیسم بالا، پیروی دقیق از دستورها و رندر دقیق متن عملکرد چشمگیری دارد.

🔗 دمو:

modelscope.cn/aigc/imageGeneration

🔗 وزنها (Turbo):

modelscope.cn/models/Tongyi-MAI/Z-Image-Turbo

#Tongyi

@asrgooyeshpardaz

👌 1

🚀 مایکروسافت مدل Fara-7B را معرفی کرد

یک مدل عاملمحور (Agentic) با ۷ میلیارد پارامتر برای انجام خودکار کارهای کامپیوتری — سریع، سبک و کاملاً محلی.

⭐ قابلیتهای کلیدی

• متخصص در کارهای وب: جستجو، رزرو، پرکردن فرمها

• تعامل شبیه انسان با کامپیوتر: ورودی اصلی آن اسکرینشات است

• اجرای کاملاً محلی (On-device) → سرعت بالا + حریم خصوصی قوی 🔒

• آموزشدیده روی ۱۴۵ هزار سناریوی واقعی با کنترل کیفیت

• عملکرد بهتر نسبت به مدلهای بزرگتر در چندین بنچمارک

• قابل استفاده در Foundry، Hugging Face (با لایسنس MIT) و «Copilot+ PC»

این نسخه فعلاً آزمایشی است و برای تست و تحقیقات منتشر شده است. 🧪

🔗 لینک منبع:

https://www.microsoft.com/en-us/research/blog/fara-7b-an-efficient-agentic-model-for-computer-use/

#AI #Microsoft #Fara #AgenticAI

@asrgooyeshpardaz

❤ 3🏆 1

پای صحبت جوان ایرانی💔

https://youtu.be/YGr1XwTZanc?si=gV9P9X6NYL_B-nD3

🤖 معرفی Agent 0: خودآموزی کامل عاملهای هوش مصنوعی بدون استفاده از دادههای بیرونی

🔍 ایدهٔ اصلی:

در Agent 0 دو عامل «معلم» و «حلکننده» بهصورت خودمختار برای یکدیگر مسئله طراحی میکنند، آن را حل میکنند و از طریق این فرایند رقابتی–تکاملی، تواناییهای همدیگر را ارتقا میدهند. این سیستم برای حل مسائل پیچیده از ابزارهایی مانند مفسر پایتون استفاده میکند.

📌 نکات کلیدی

✅ بدون نیاز به دادهٔ خارجی؛ همهچیز داخل سیستم ساخته و حل میشود

✅ تکیه بر مفسر کد برای مسائل دشوار

✅ افزایش ۱۸٪ در عملکرد ریاضی و ۲۴٪ در منطق برای مدل Qwen3-8B

✅ سختی مسائل در هر چرخه افزایش مییابد

🚀 نتیجه: یک سامانهٔ کاملاً خودکار، خودبهبودیاب و خودآموز که از بسیاری روشهای موجود بهتر عمل میکند

📄 مقاله و کد

مقالهٔ پژوهشی:

https://arxiv.org/abs/2511.16043v1

کد منبع:

https://github.com/aiming-lab/Agent0

#AI #GenerativeAgents #SelfLearning #Research

@asrgooyeshpardaz

👍 2👌 2🔥 1

❇️ آغاز یک پروژهٔ ملی برای توسعهٔ هوش مصنوعی در ایالات متحده

رئیسجمهور آمریکا با امضای یک فرمان اجرایی، دستور ایجاد یک پلتفرم یکپارچهٔ دولتی در حوزهٔ هوش مصنوعی را صادر کرد. این پروژه که اجرای آن به وزارت انرژی سپرده شده، قرار است چرخهٔ پیشرفت علمی را در حوزههای زیستفناوری و انرژی از بازههای چندساله به چند روز کاهش دهد.

در این ابتکار، ظرفیت ۱۷ مرکز پژوهشی فدرال بسیج میشود. ابررایانهها و حجم عظیم دادههای علمی ذخیرهشده طی دههها، برای آموزش مدلهای تخصصی بهکار گرفته خواهند شد. این پلتفرم جدید به عاملهای هوش مصنوعی امکان میدهد تا بهصورت مستقل آزمایشها را برنامهریزی کنند، فرضیهها را بیازمایند و در حوزههای شیمی، زیستشناسی و مهندسی پیشبینی تولید کنند.

لینک: whitehouse.gov

❇️ ادغام کامل حالت گفتاری و متنی در ChatGPT

شرکت OpenAI بهروزرسانی جدیدی ارائه کرده که مرز میان ورودی صوتی و متنی را از میان برمیدارد. از این پس، چت صوتی مستقیماً در همان پنجرهٔ اصلی مکالمه فعال است و کاربران میتوانند بدون تغییر حالت، میان گفتار و نوشتار جابهجا شوند.

در جریان گفتگوهای صوتی، امکان مشاهدهٔ آزادانهٔ تاریخچهٔ پیامها، تصاویرِ تولیدشده یا نقشهها وجود دارد و پاسخهای دستیار نیز بهطور خودکار به متن تبدیل میشود. این قابلیت هماکنون در نسخهٔ وب و اپلیکیشنهای موبایل فعال است. برای کسانی که حالت صوتی قدیمی را ترجیح میدهند، امکان بازگردانی آن در بخش تنظیمات (Voice Mode) باقی مانده است.

لینک: OpenAI در شبکهٔ X

❇️ انتشار مدل Fara-7B برای کنترل رایانه توسط مایکروسافت

مایکروسافت مدل Fara-7B را معرفی کرده است؛ یک مدل عاملمحور (Agentic) و فشرده بر پایهٔ Qwen2.5-VL که برای کار خودمختار با رابطهای کاربری طراحی شده است. این مدل میتواند اسکرینشاتها را تحلیل کند، موقعیت دقیق پیکسلها را پیشبینی کند و فرمانهای لازم برای ماوس و صفحهکلید را تولید کند.

مدل Fara-7B در بنچمارکها عملکردی بهتر از مدلهای مشابه داشته و اجرای وظایف را با هزینهای بسیار کمتر انجام میدهد—میانگین هزینهٔ هر جلسه کمتر از ۳ سنت است. وزنهای مدل نیز با مجوز MIT در Hugging Face منتشر شدهاند.

لینک: microsoft.com

❇️ توسعهٔ مدل جدید برای تشخیص بیماریهای نادر ژنتیکی در هاروارد

دانشکدهٔ پزشکی هاروارد مدل popEVE را معرفی کرده؛ شبکهای عصبی که میتواند با دقت بالا جهشهای پاتولوژیک را در ژنوم شناسایی کند و در تشخیص بیماریهای نادر ارثی که گاهی سالها علتشان ناشناخته میماند، کمک کند.

مدل popEVE ترکیبی از هوش مصنوعی مولد، مدلهای زبانی پروتئین و دادههای جمعیتشناسی ژنتیک است. این سیستم قادر است خطر جهشهایی را که در ژنهای کاملاً متفاوت رخ دادهاند، با یک معیار یکسان ارزیابی کند—کاری که مدلهای پیشین در آن ناتوان بودند. این روش روی نمونهای شامل ۳۰ هزار بیمار آزمایش شد و در یکسوم موارد علت بیماری را تشخیص داد. افزون بر این، ۱۲۳ ژن جدید را شناسایی کرد که پیشتر هیچ ارتباطی با بیماریها نداشتند.

لینک: harvard.edu

❇️ نبرد Grok 5 با قهرمانان League of Legends در سال ۲۰۲۶

ایلان ماسک یک آزمایش بلندپروازانه را اعلام کرده است: مدل Grok 5 قرار است در سال ۲۰۲۶ با قدرتمندترین تیمهای حرفهای League of Legends رقابت کند. این مسابقه صرفاً یک نمایش نخواهد بود، بلکه آزمونی تعیینکننده در مسیر رسیدن به هوش عمومی مصنوعی (AGI) بهشمار میرود.

برای حفظ عدالت رقابتی، محدودیتهای فنی سختگیرانهای اعمال خواهد شد. مدل هیچ دسترسی مستقیمی به API بازی نخواهد داشت و باید همانند انسان، از طریق دوربینی که نمایشگر را ثبت میکند، محیط را ببیند. سرعت واکنش و نرخ کلیک نیز به سطح تواناییهای انسانی محدود میشود. انتظار میرود Grok 5 مکانیکهای پیچیدهٔ این بازی MOBA را از صفر و تنها از طریق مطالعهٔ مستندات و تجربهٔ مستقیم در جریان بازی بیاموزد.

لینک: Elon Musk در شبکهٔ X

@asrgooyeshpardaz

#news #ai

❤ 6👏 2👌 2🔥 1

⚡️ مدل HunyuanOCR — مدل OCR متنباز ۱B پارامتری تنسنت

تنسنت مدل HunyuanOCR را منتشر کرده؛ یک OCR فوقسریع و سبک با فقط ۱ میلیارد پارامتر که در بِنچمارکها عملکردی در سطح مدلهای بزرگتر نشان میدهد.

🚀 عملکرد

860 در OCRBench (بهترین مدل زیر 3B)

94.1 در OmniDocBench (پردازش اسناد پیچیده)

🌐 قابلیتها

🔸تشخیص متن محیطی، دستنویس، جداول، فرمولها، HTML، LaTeX

زیرنویس ویدئو

🔸ترجمهٔ مستقیم تصویر 👈 متن در ۱۴ زبان

🔸کاملاً End-to-End (بدون پایپلاین چندمرحلهای)

🌍 پشتیبانی از زبان فارسی؟

✅سرویس OCR فارسی: به احتمال زیاد پشتیبانی میشود (مدل بیش از ۱۰۰ زبان را پوشش میدهد).

❌ترجمهٔ تصویر به فارسی: خیر (فارسی در میان ۱۴ زبان ترجمه نیست).

🔗 لینکها

Project Page

GitHub

Hugging Face

Technical Report

@asrgooyeshpardaz

❤ 1🔥 1🍾 1

🧠 ماشین فکر پیوسته (CTM): معماری نوینی از Sakana AI برای افزودن بُعد زمانی به مدلهای هوش مصنوعی

پژوهش تازهی Sakana AI با عنوان Continuous Thought Machine (CTM) کوششی است برای نزدیکتر کردن رفتار مدلهای هوش مصنوعی به دینامیک واقعی مغز. این معماری با الهام از زمانبندی عصبی، همگامسازی نورونها و پردازش تدریجی، تلاش میکند «تفکر» را بهعنوان یک فرآیند زمانی در مدل وارد کند؛ نه صرفاً یک نگاشت ورودی–خروجی.

🔍 مسأله از کجا آغاز شد؟

مدلهای عصبی متعارف، فرآیند تصمیمگیری را به صورت لحظهای و بدون بهرهگیری از زمان داخلی انجام میدهند؛ در حالیکه مغز انسان با توالیهای زمانی، همگامسازی نورونها و بازنگری پیوسته در فعالیتها عمل میکند.

روش CTM دقیقاً برای بازنمایی همین ویژگی طراحی شده است:

مدلی که بتواند به یک ورودی ثابت، در طول زمان فکر کند.

⚙️ هستهی معماری CTM چیست؟

۱. زمانبندی داخلی (Internal Ticks)

CTM بُعد جدیدی به مدل اضافه میکند:

مدل میتواند در چندین «تیک زمانی» پیاپی، روی یک ورودی ثابت فکر و بازنگری کند. این یعنی پردازش لایهبهلایه جای خود را به پردازش زمانیِ درونی میدهد.

۲. مدلسازی در سطح نورون (NLM)

هر نورون، برخلاف شبکههای معمول، دارای مدل مستقل با پارامترهای اختصاصی است.

این نورون نه یک تابع ساده، بلکه یک پردازندهی کوچک است که تاریخچهی فعالسازی خود را بررسی میکند.

۳. همگامسازی نورونی (Neural Synchronization)

نوآورانهترین بخش CTM، استخراج ماتریس همگامسازی نورونهاست:

با دنبالکردن فعالسازی نورونها در طول زمان، مدلی ایجاد میشود که روابط و هماهنگی میان واحدهای عصبی را بهطور مستقیم نمایش میدهد.

این همگامسازی، نقش یک «نمایندگی با سطح بالاتر» را برای تصمیمگیری برعهده میگیرد.

۴. تعامل مداوم با داده

در هر تیک زمانی، ورودی دوباره در اختیار مدل قرار میگیرد؛ اما تصمیم نهایی متکی بر جمعبندی پردازشهای زمانی است—not لحظهای.

📊 نتایج اولیهی CTM چه میگویند؟

پردازش تطبیقی: با افزایش تیکهای زمانی، دقت مدل افزایش مییابد؛ یعنی مدل میتواند «بیشتر فکر کند».

حل مازهای دوبعدی: CTM در مسیریابی موفق عمل کرده و حتی مسیرهایی طولانیتر از نمونههای آموزشی را طی کرده است.

یادگیری وظایف محاسباتی: در وظایفی مانند تشخیص زوجیت یک رشته یا پرسشوپاسخ روی MNIST، CTM توانسته از پردازش زمانی برای استدلال استفاده کند.

🌐 چرا CTM برای جامعهی عاملهای تولیدی (Generative Agents) مهم است؟

معماریهای عاملهای کنونی اغلب واکنشی و خطیاند.

روش CTM امکان میدهد عاملها دارای فرآیند تفکر داخلی باشند:

مشاهده 👈 پردازش زمانی 👈 تصمیم

این ویژگی میتواند زمینهساز عاملهایی شود که در شرایط پیچیده، نیازمند بازنگری، حافظهی درونی و کنترل تطبیقیاند.

افزونبراین، CTM از مدلهای مغزی الهام گرفته است؛ رویکردی که برای ساخت عاملهایی با رفتار طبیعیتر اهمیت دارد.

✔️ نقاط قوت

افزودن بُعد زمانی واقعی به مدل

استفاده از الگوی هماهنگسازی عصبی

نتایج امیدبخش در وظایف مختلف

⚠️ چالشها و پرسشهای باز

هزینهی محاسباتی ماتریس همگامسازی

تعمیم به مقیاس بزرگتر

مشخصنبودن نحوهی تلفیق CTM با معماریهای عاملهای چندعاملی و سیستمهای عملیاتی

📝 جمعبندی برای انتشار در تلگرام

روش CTM را میتوان اینگونه معرفی کرد:

«معماریای که به مدلهای هوش مصنوعی توانایی فکر کردن در طول زمان میدهد و هماهنگسازی نورونی را بهعنوان یک نمایندگی محوری وارد یادگیری میکند.»این پژوهش میتواند مسیر جدیدی برای توسعهی عاملهای پویا، انعطافپذیر و شبیهتر به سیستمهای زیستی بگشاید. 🔗لینک مقاله: https://pub.sakana.ai/ctm/ @asrgooyeshpardaz

🔥 2🤔 1

🚀 رویکرد FLEX: تکامل پیوستهی عاملهای هوش مصنوعی بر پایهی یادگیری از تجربه

تیمی از پژوهشگران دانشگاه Tsinghua رویکرد تازهای با نام FLEX معرفی کردهاند؛ روشی که به مدلهای زبانیِ عاملمحور اجازه میدهد بدون هیچگونه بهروزرسانی پارامتری (بدون Backprop) بهطور مداوم رشد کنند و بهتر شوند.

🔍 ایدههای اصلی FLEX

عاملها از موفقیتها و خطاهای خود درس میگیرند و یک «کتابخانه تجربه» میسازند.

یادگیری کاملاً بدون گرادیان است؛ یعنی مدل اصلی ثابت میماند.

این کتابخانه تجربه میتواند گسترش پیدا کند و بین عاملها به ارث برسد.

📊 نتایج تجربی

ریاضی (AIME25): افزایش ۲۳٪

شیمی (USPTO50k): افزایش ۱۰٪

زیستفناوری (ProteinGym): افزایش ۱۴٪

✨ اثرات کلیدی

ظهور نوعی قانون مقیاسپذیری با تجربه؛ هرچه تجربه بیشتر، عملکرد بهتر.

انتقال دانش بین عاملها بدون تغییر مدل پایه.

بهبود تفسیرپذیری، چون تجربهها صریح و قابل تحلیلاند.

روش FLEX میتواند مسیری تازه بهسوی ساخت نسل جدیدی از عاملهای هوش مصنوعی باز کند؛ عاملهایی که مانند یک سیستم زنده، با تجربه تکامل پیدا میکنند 🌱

🔗 منبع پژوهش: arXiv (نسخه ۱)

#AI #Agents #Research

@asrgooyeshpardaz

❤ 1👍 1🔥 1🤝 1

📝 گوگل دو قابلیت قدرتمند جدید را به NotebookLM افزوده است

✨ ساخت مجموعه اسلاید (Slide Decks) — تولید پرزنتیشن حرفهای کاملاً بر اساس منابعی که شما بارگذاری کردهاید.

📊 اینفوگرافیک (Infographics) — ساخت اینفوگرافیک و خلاصههای بصری از دادهها و متون ورودی.

نکات مهم:

✅ فقط از دادههای شما استفاده میکند؛ هیچگونه «توهم» یا محتوای خارج از منبع تولید نمیشود.

🎨 بهصورت خودکار انواع عناصر بصری مانند نمودار، دیاگرام و کلیپآرت اضافه میکند.

🔄 ساختار منسجم و انتقالهای نرم بین اسلایدها

✏️ امکان ویرایش و شخصیسازی نتایج

💡 این قابلیتها با تکیه بر مدل Nano Banana Pro که بهتازگی معرفی شده، فعال شدهاند.

📌 بهنظر میرسد NotebookLM کمکم در حال تبدیل شدن به رقیبی جدی برای PowerPoint و Canva است 🚀

🔗منبع: وبلاگ گوگل

#هوشمصنوعی #گوگل

@asrgooyeshpardaz

👍 5❤🔥 2🔥 2❤ 1🤝 1

🤖 شرکت Anthropic مدل پرچمدار جدید خود را معرفی کرد: Opus 4.5

🚀 کارایی و عملکرد

قدرتمندترین مدل Anthropic برای کدنویسی و کارهای پیچیده نرمافزاری

رکوردشکنی در SWE-bench

عملکردی بهتر از برترین مهندسان انسانی در آزمونهای تخصصی مهندسی

💡 تواناییها

انجام پژوهشهای عمیق و چندمرحلهای

حل خلاقانهی مسائل دشوار و باز

بهبود چشمگیر در بینایی مدل و استدلال ریاضی

🛡 امنیت

امنترین مدل Anthropic تا امروز

مقاوم در برابر پرومپتاینژکشن و دستکاریهای مخرب

💻 دسترسی و قیمت

هماکنون در API و اپلیکیشنها فعال است

کاهش قیمت به ۵ دلار / ۲۵ دلار برای هر میلیون توکن

انتشار بهروزرسانی برای Claude Code، افزونه Excel و افزونه Chrome

✨ تجربه کاربران اولیه تستکنندگان گزارش کردهاند که مدل درک بسیار بالایی از مسائل پیچیده دارد و بدون نیاز به توضیحات اضافه، مسیر حل را پیدا میکند.

🔗 منبع:

https://www.anthropic.com/news/claude-opus-4-5

#هوشمصنوعی #آنتروپیک

@asrgooyeshpardaz

❤ 1🔥 1